DeepSeek V3 0324: تحديث جديد يتصدر فئته ويتفوق على النماذج البارزة

كشفت شركة DeepSeek الصينية يوم 24 مارس الماضي عن نسخة محدثة من نموذجها اللغوي الكبير مفتوح المصدر V3.

يحمل الإصدار اسم DeepSeek-V3-0324، ويقدم أداءً متقدماً خاصة في المهام التي لا تحتاج لتفكير عميق. كما أظهر تطوراً في مهارات البرمجة وحل المسائل الرياضية.

DeepSeek V3-0324 في الصدارة

حقق نموذج DeepSeek V3-0324 إنجازاً مميزًا في مجال الذكاء الاصطناعي.

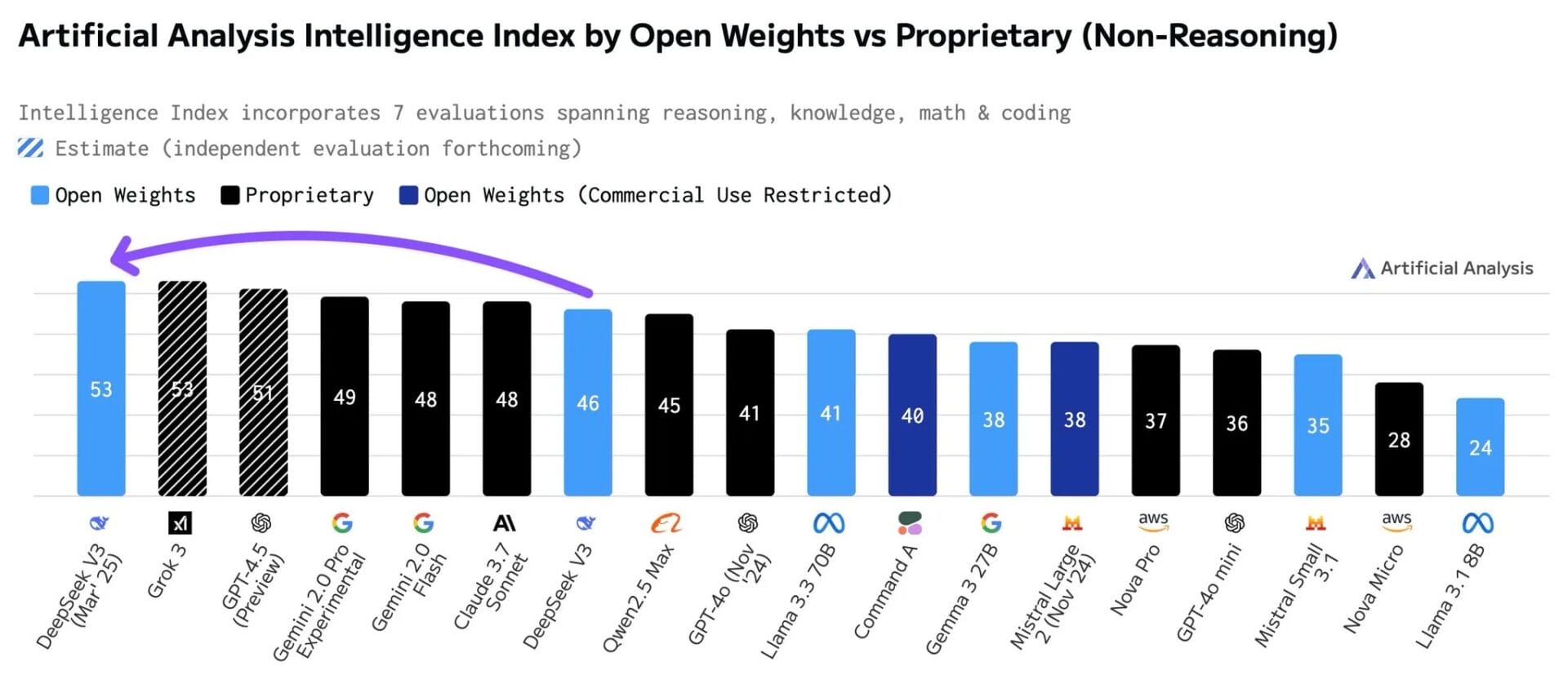

فقد أصبح النموذج الأعلى تقييماً ضمن فئة النماذج التي لا تعتمد على التفكير المعقد (non-reasoning). جاء ذلك وفقاً لمؤشر «Artificial Analysis Intelligence Index«.

وتجاوز النموذج الجديد العديد من النماذج التجارية المغلقة مثل Gemini 2.0 Pro من جوجل وClaude 3.7 Sonnet من Anthropic، بالإضافة إلى Llama 3.3 70B من ميتا.

وبحسب منصة Artificial Analysis، فإن هذه هي المرة الأولى التي يتفوق فيها نموذج مفتوح المصدر على جميع النماذج غير التحليلية المغلقة.

سرعة النماذج غير التحليلية مقابل التحليل المعقد

رغم هذا التقدم، لا يزال DeepSeek V3-0324 خلف النماذج المصممة للتفكير المعقد (reasoning models).

وتشمل هذه الفئة نماذج مثل DeepSeek R1 (من نفس الشركة) ونماذج أخرى من OpenAI وعلي بابا.

فالمهام التي تحتاج لحل مشكلات معقدة تحتاج إلى قدرات تحليلية أعمق، وهذا يبقى مجال تفوق نماذج التفكير.

ولكن تشير نتائج V3 في نفس الوقت إلى إمكانية اعتماد حلول مفتوحة المصدر في المجالات التي تتطلب استجابة فورية مثل الدردشة الفورية، خدمة العملاء، والترجمة المباشرة

تحسينات في البرمجة والرياضيات

لم يقتصر التحديث على الأداء العام، حيث تشير بيانات الشركة إلى قفزة كبيرة في قدرات حل المسائل الرياضية.

وسجل النموذج 59.4 نقطة في اختبار الرياضيات الأمريكي AIME، بينما كان سلفه قد سجل 39.6 نقطة فقط.

كذلك، تحسنت مهارات النموذج في مجال البرمجة.

وارتفع تقييمه في مقياس LiveCodeBench بمقدار 10 نقاط، ليصل إلى 49.2.

كما ذكرت الشركة أيضاً تطويراً لقدرات تطوير واجهات الويب الأمامية وتحسيناً للكتابة باللغة الصينية.

مميزات DeepSeek V3 الجديد

يستند V3 المحسن إلى بنية ضخمة تضم حوالي 685 مليار بارامتر (معلمة)، يبلغ عدد البارامترات النشطة 37 ملياراً.

ويمثل هذا زيادة طفيفة عن سلفه V3 الذي كان يضم 671 مليار بارامتر.

ويعتمد النموذج على تصميم خليط الخبراء (MoE)، والذي يغير طريقة عمل النماذج اللغوية.

فبدلًا من استخدام كل قدراته الضخمة (685 مليار معلمة) دفعة واحدة، يختار النموذج جزءاً محدداً فقط (حوالي 37 مليار معلمة) للتعامل مع كل مهمة.

تختلف هذه الطريقة عن النماذج التقليدية التي تستخدم كامل معلماتها في كل عملية.

بالإضافة لذلك، يضم النموذج تقنيتين جديدتين مهمتين:

الأولى هي الانتباه الكامن متعدد الرؤوس (MLA)، التي تساعده على فهم السياق بشكل أفضل عند التعامل مع نصوص طويلة جداً.

بينما الثانية هي التنبؤ متعدد الوحدات (MTP). وبفضلها، ينتج النموذج عدة أجزاء من النص دفعة واحدة بدلًا من إنتاج جزءاً واحداً ثم التالي كما هو معتاد.

وقد أدى دمج هاتين التقنيتين معاً إلى زيادة كبيرة في سرعة إخراج النص. تصل هذه الزيادة لنحو 80 بالمئة.

بالإضافة إلى ذلك، يستطيع النموذج معالجة سياق يصل طوله إلى 128 ألف توكن (وحدة نصية).

لكن عبر واجهة برمجة تطبيقات DeepSeek، يقتصر السياق على 64 ألف توكن. يظل النموذج نصياً فقط ولا يدعم الوسائط المتعددة.

ومن التغييرات الهامة أيضاً، اعتماد ترخيص MIT المفتوح المصدر بالكامل. يختلف هذا عن الترخيص التجاري الخاص بالشركة الذي استخدم مع V3 الأصلي، حيث يتيح ترخيص MIT مرونة أكبر للمطورين والشركات.

تقدم النماذج مفتوحة المصدر

يضيق التقدم الذي يحرزه DeepSeek الفجوة بين النماذج مفتوحة المصدر والنماذج التجارية المغلقة.

قبل ثلاثة أشهر، كان DeepSeek V3 قريباً من أداء نماذج جوجل و Anthropic ولكنه لم يتجاوزها.

لكن الآن، لا يتصدر V3-0324 البدائل المفتوحة المصدر فحسب، بل يتفوق أيضاً على كل المنافسين التجاريين في فئته (غير المعتمدة على التفكير).

وترى «Artificial Analysis» أن هذا الإصدار قد يكون أكثر إثارة للإعجاب من إصدار R1 (نموذج التفكير).

الإصدار متاح على منصة Hugging Face الشهيرة وموقع الشركة، وحظي سريعاً بشعبية كبيرة وتعليقات إيجابية من مجتمع المطورين.

جرب النموذج الآن. لاستخدامه، أوقف تفعيل خيار «Deep Think» الموجود بواجهة الدردشة، والخاص بنموذج R1.

ومع كل هذه القدرات التي تميز بها V3-0324، يتطلع الكثيرون لنموذج R2 القادم من الشركة، على أمل تحقيق قفزة أخرى في أداء الذكاء الاصطناعي.