شاومي تدخل سباق الذكاء الاصطناعي بقوة بنموذج MiMo-7B-RL

كشفت شركة شاومي عن نموذجها مفتوح المصدر MiMo-7B-RL، وهو نموذج لغوي ضخم مخصص لمهام الاستدلال الرياضي وتوليد الشيفرات البرمجية.

يأتي النموذج الجديد بعدد معقول من المعاملات نحو 7 مليارات فقط.

ورغم حجمه الصغير، أشارت الشركة إلى أنه يحقق أداءً يوازي نماذج أكبر بكثير مثل o1-mini من OpenAI وQwen-32B من علي بابا.

جودة التدريب: مفتاح أداء MiMo

ترى شاومي أن مفتاح النجاح في نماذج الذكاء الاصطناعي لا يكمن فقط في الحجم، بل في جودة التدريب الأساسي.

ولهذا السبب، خضعت مرحلة التدريب المبدئي لنموذج MiMo لتعديلات دقيقة لزيادة كثافة «أنماط الاستدلال» داخل البيانات المستخدمة.

وشملت هذه العملية تطوير أدوات استخراج النصوص الفنية والبرمجية، واستخدام فلاتر متعددة الأبعاد لتركيز محتوى البيانات على المشكلات المنطقية.

كما ابتكرت الشركة إستراتيجية بيانات من ثلاث مراحل اعتمدت على نحو 25 تريليون رمز تدريبي، وهو ما عزز قدرة النموذج على فهم العلاقات المعقدة.

وجرى تطبيق تقنية التنبؤ بعدة رموز متتالية (Multiple-Token Prediction) بهدف تسريع عملية توليد الإجابات وتحسين جودة الفهم السياقي.

مرحلة التعلم المعزز لزيادة الدقة والكفاءة

بعد بناء نموذج MiMo-7B الأساسي، انتقلت شاومي إلى مرحلة التدريب بالتعلم المعزز (RL)، بالاعتماد على مجموعة مختارة من 130 ألف مسألة في الرياضيات والبرمجة.

وتم التحقق من كل مسألة عبر اختبارات أو أساليب تحقق رقمية لضمان موضوعية النتائج.

ولتفادي مشكلات المكافآت الضعيفة في توليد الشيفرات المعقدة، طورت شاومي نظامًا فريدًا يمنح النموذج درجات جزئية عند اجتياز اختبارات فرعية داخل كل مسألة، وهو ما يتيح للنموذج فهمًا تدريجيًا وتعلّمًا أكثر استقرارًا.

كذلك، اعتمدت الشركة على بنية تحتية متقدمة تُعرف باسم «محرك الطرح السلس» (Seamless Rollout Engine)، قلصت من أوقات التوقف على وحدات المعالجة الرسومية، وحققت تسارعًا في التدريب بنسبة 2.29 مرة، وتحسينًا في سرعة التحقق بنسبة 1.96 مرة.

إصدارات متعددة

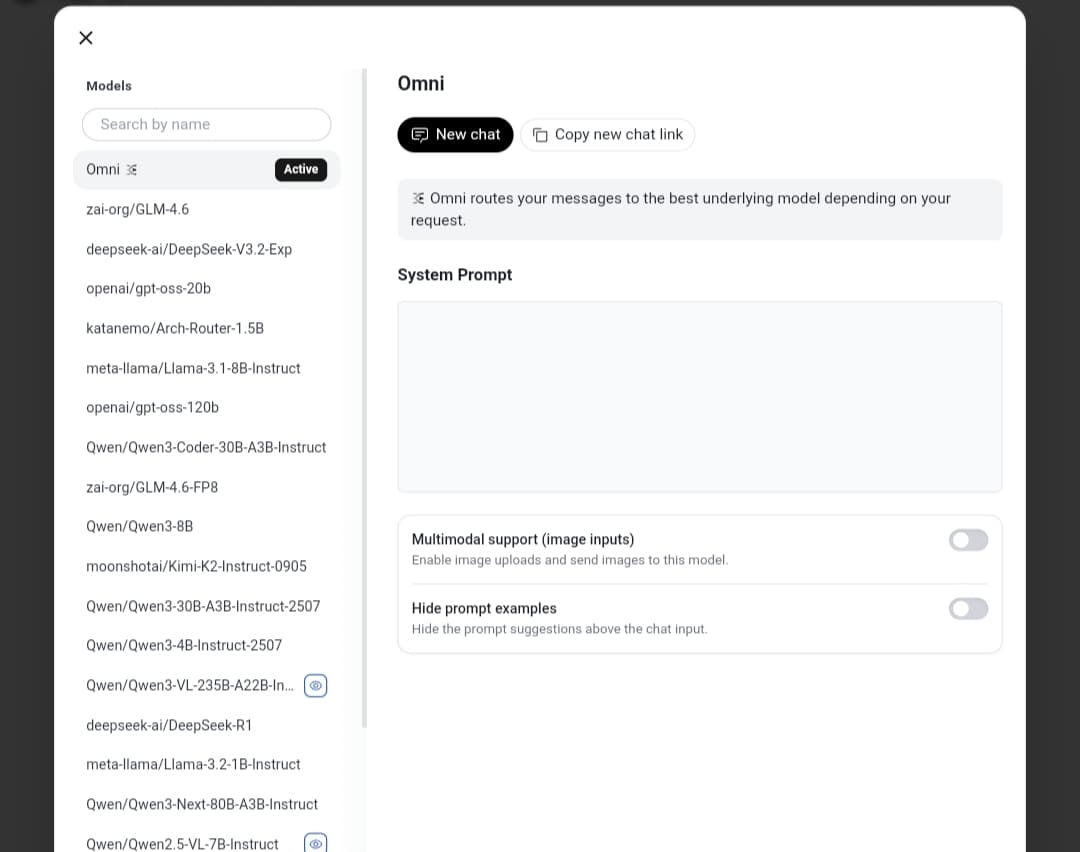

أطلقت شاومي أربعة إصدارات ضمن سلسلة MiMo-7B:

- MiMo-7B-Base: النموذج الأساسي بقدرات منطقية أولية قوية

- MiMo-7B-RL-Zero: نسخة مدعومة بالتعلم المعزز مباشرة من الأساس

- MiMo-7B-SF: نسخة معدلة بالتعلم الخاضع للإشراف

- MiMo-7B-RL: الإصدار النهائي عالي الأداء

ووفقًا للاختبارات، سجل MiMo-7B-RL أرقامًا ممتازة:

| الاختبار | نسبة النجاح |

|---|---|

| الرياضيات | |

| MATH-500 | 95.8% |

| AIME 2024 | 68.2% |

| AIME 2025 | 55.4% |

| البرمجة | |

| LiveCodeBench v5 | 57.8% |

| LiveCodeBench v6 | 49.3% |

تظهر هذه النتائج أن النموذج يتفوق على العديد من المنافسين الكبار رغم حجمه الأصغر، مما يضعه ضمن أفضل النماذج في فئة النماذج المتخصصة بالكود والرياضيات.

متاح للجميع عبر Hugging Face

وفرت شاومي نماذج MiMo على منصة Hugging Face مع تعليمات تشغيل مفصلة.

ويمكن استخدام النموذج بسهولة عبر مكتبة Transformers أو إصدار vLLM المخصص من شاومي، مع دعم لميزة التنبؤ المتعدد لتسريع الاستدلال.

الوصول إلى النموذج

https://huggingface.co/XiaomiMiMo