QwQ-32B: كل ما تريد معرفته عن نموذج على بابا الجديد منافس DeepSeek-R1

ما هو QwQ-32B؟

QwQ-32B هو الإصدار الجديد الذي أطلقه فريق Qwen التابع لـ Alibaba في الأسبوع الأول من شهر مارس 2025.

وهو نموذج ذكاء اصطناعي مفتوح المصدر يحتوي على 32 مليار مَعلَمة (Parameters)، مستهدفًا الذكاء الاصطناعي القائم على الاستدلال المنطقي.

وعلى الرغم من أنه أصغر من بعض النماذج اللغوية الرائدة، إلا أنه يتميز بقدرة عالية على الاستنتاج، مع التركيز على التحليل العميق بدلًا من الاكتفاء بإنتاج النصوص.

ونظرًا لكونه مفتوح المصدر، يسمح للباحثين والمطورين بفرصة استخدامه بحرية وتعديله وفقًا لاحتياجاتهم, وهو ما سنتطرق إليه لاحقًا.

QwQ-32B Preview: نسخة تجريبية تم إطلاقها العام الماضي

اعتمدت بعض الشركات إطلاق نسخ أولية تجريبية من نماذج التفكير المتسلسل قبل الكشف عن إصداراتها الرئيسية.

وكانت البداية مع o1 preview من OpenAI، الذي كان مرحلة تجريبية قبل الإعلان عن النموذج الأساسي o1 في ديسمبر.

وكذلك تم إطلاق النسخة الأولى من DeepSeek-R1 العام الماضي، قبل الإطلاق النهائي لنسختها الرئيسية مفتوحة المصدر في يناير.

وفي هذا السياق، تم تقديم QwQ-32B-preview في نوفمبر 2024 كإصدار أولي لمنافسة نموذج o1-preview من OpenAI.

كيف تطور QwQ-32B ليصبح نموذجًا قويًا؟

لا ينتمي QwQ-32B إلى فئة النماذج التقليدية العامة التي تعتمد على توليد النصوص بشكل محادثاتي مثل GPT-4.5 أو DeepSeek-V3.

بل يندرج تحت فئة النماذج المتخصصة في الاستدلال المنطقي، والتي تهدف إلى تحليل المشكلات المعقدة والتوصل إلى حلول ممنهجة.

لذلك، إذا كنت تبحث عن مساعد للكتابة الإبداعية أو التلخيص، فهذا النموذج ليس الخيار الأمثل.

وما يميز QwQ-32B هو طريقة تدريبه، التي تجمع بين مزيج من:

- أساليب التدريب التقليدية: مرحلة التدريب المسبق والتخصيص (Fine-Tuning)،

- بالإضافة إلى أحدث تقنيات التعلم المعزز (Reinforcement Learning)، وهو ما يميزه عن العديد من النماذج الأخرى التي تركز فقط على التوليد التنبئي للنصوص.

لكن ما الفرق؟

تعتمد أغلب نماذج اللغة التقليدية على التنبؤ بالكلمات التالية بناءً على كميات هائلة من البيانات النصية. هذا يجعلها ممتازة في توليد النصوص، لكنها ليست دائمًا الأفضل في حل المشكلات المنطقية.

أما التعلم المعزز، فهو أشبه بلعبة مكافآت، فالنموذج لا يكتفي بإنتاج النصوص، بل يحصل على «مكافأة» عندما يصل إلى حل صحيح أو يتبع مسار تفكير منطقي.

ومن هنا يتضح كيف تحسنت قدراته في التعامل مع المشكلات الرياضية، البرمجة، والتفكير المنطقي المتقدم.

1

حجم النموذج الأصغر

2

التدريب الذكي

3

نافذة السياق الواسعة

كفاءة QwQ-32B

مميزات QwQ-32B: كيف تفوقت كفاءته على حجمه؟

نموذج صغير بقدرات استدلال عالية

على الرغم من أن QwQ-32B يحتوي على 32 مليار مَعلَمة فقط، إلا أن نتائجه قريبة جدًا من DeepSeek-R1، الذي يتكون من 671 مليار معلمة، مع تنشيط 37 مليار منها أثناء الاستخدام.

نافذة سياقية ضخمة

يتعامل النموذج مع ما يصل إلى 131,072 رمزًا دفعة واحدة.

وبالتالي يستطيع معالجة كميات كبيرة من المعلومات في آنٍ واحد، مثل المهام التي تتطلب تحليل نصوص طويلة.

التفكير الديناميكي (Agentic Thinking)

يتميز بالقدرة على تعديل طريقة تفكيره بناءً على المعلومات التي يستقبلها، بدلًا من مجرد الاعتماد على النصوص المخزنة مسبقًا.

QwQ-32B مقابل DeepSeek-R1: هل الحجم يهم؟

رغم أن DeepSeek-R1 أكبر بـ 20 مرة، إلا أن QwQ-32B يقترب جدًا من مستواه في العديد من الاختبارات. إليك مقارنة واضحة بالأرقام:

مرر الجدول أفقياً إن كنت تستخدم الهاتف

| المعيار | QwQ-32B | DeepSeek-R1 |

o1-mini (OpenAI) |

|---|---|---|---|

| AIME24 (الرياضيات) | 79.5 | 79.8 | 63.6 |

| IFEval (الاستدلال الرمزي) | 83.9 | 83.1 | 84.8 |

| LiveCodeBench (البرمجة) | 63.4 | 65.9 | 53.8 |

| LiveBench (حل المشكلات) | 73.1 | 71.6 | 59.1 |

| BFCL (الاستدلال الوظيفي) | 66.4 | 60.3 | 62.8 |

ما يلفت النظر أن QwQ-32B يتفوق على DeepSeek-R1 في بعض المعايير، مثل الاستدلال الوظيفي، وهو قدرة النموذج على استخدام معرفته لحل المشكلات أو الإجابة عن الأسئلة بطريقة منطقية.

ولذلك، حجم النموذج ليس العامل الحاسم دائمًا – فالطريقة التي يتم تدريب النموذج عليها تلعب دورًا أكبر.

وهو ما قد يؤدي مستقبلًا إلى تطوير نماذج أصغر حجمًا لكنها أكثر ذكاءً.

كيف يمكنك الوصول إلى QwQ-32B؟

التجربة المباشرة

يمكنك التفاعل مع النموذج من خلال موقع Qwen Chat.

بعد التسجيل، اختر QwQ-32B من القائمة، ثم اضغط على زر «Thinking» في نافذة الدردشة لتفعيل النموذج.

وابدأ بطرح المسائل الرياضية أو البرمجية لترى كيف يعالجها.

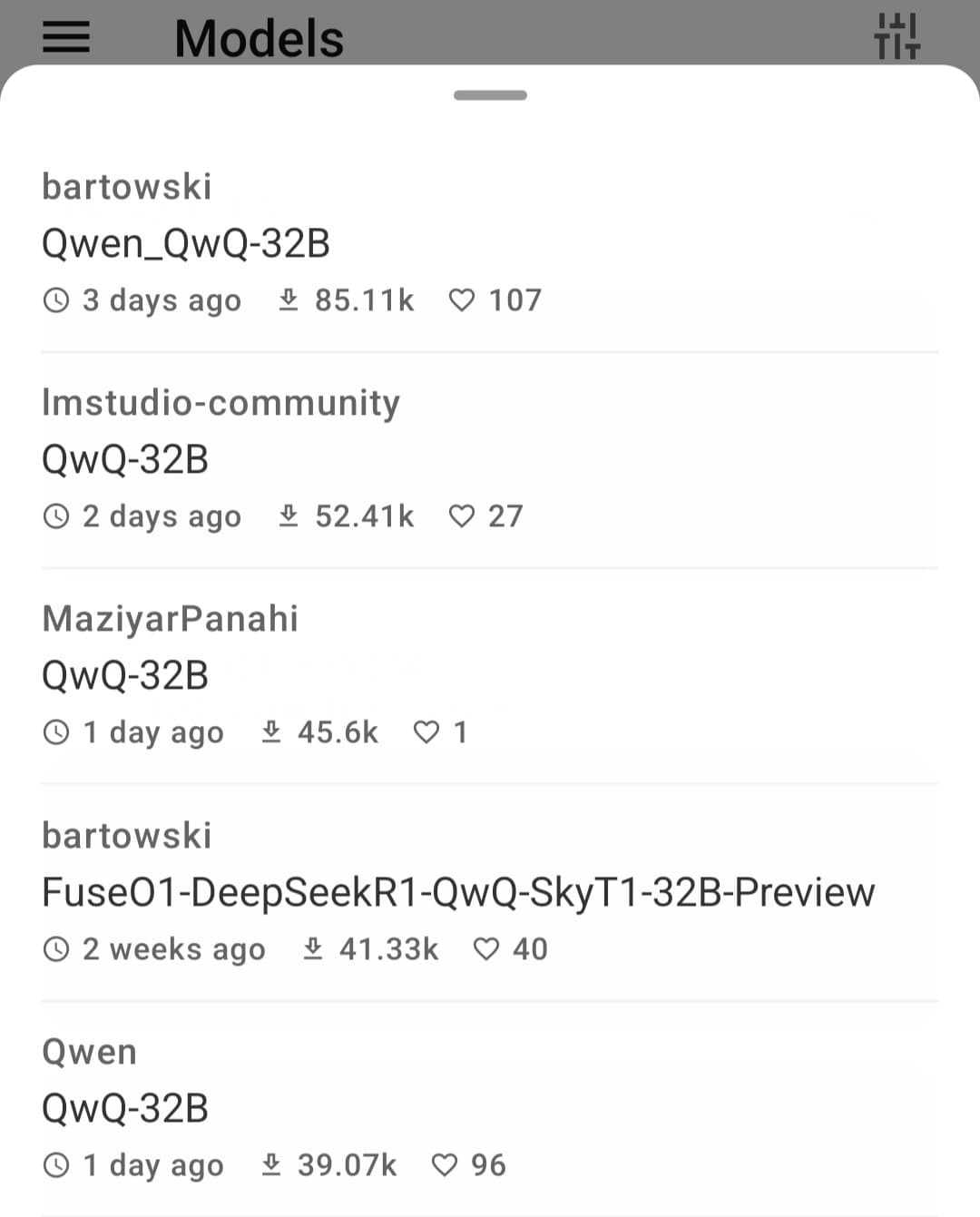

التحميل والتشغيل عبر Hugging Face وModelScope

إذا كنت مطورًا وترغب بدمج QwQ-32B في تطبيقاتك، تستطيع تحميله عبر Hugging Face أو ModelScope.

التشغيل محليًا

لتشغيله على جهازك، ستحتاج إلى بطاقات رسومية قوية مثل A100 أو H100.

أما إن كان جهازك قدرته محدودة، يمكنك استخدام تقنيات مثل التكميم (Quantization). أي ضغط النموذج لتوفير استهلاك الذاكرة، وإن كان ذلك قد يؤثر قليلاً على الأداء.

تحميل وتشغيل QwQ-32B على الهاتف بدون من مجانًا

لتحميل وتنزيل QwQ-32B:

اطلع على طريقة تشغيل نماذج الذكاء الاصطناعي مفتوحة المصدر عبر الهاتف بدون إنترنت وبشكل مجاني، وذلك من خلال تطبيق PocketPal.

عقب فتح التطبيق، اكتب بشريط البحث اسم النموذج، ستجد العديد من المطورين يتيحون لك تنزيله.

اضغط على أي منهم وقم بتحميله.

الأسئلة الشائعة

هل QwQ-32B مجاني؟

نعم، QwQ-32B متاح بمصدر مفتوح بشكل كامل، ويمكن الوصول إليه عبر منصات مثل Hugging Face و ModelScope.

ومع ذلك، يجب الأخذ في الاعتبار أن تشغيله على أجهزتكم المحلية قد يستلزم توفير موارد حاسوبية ذات تكلفة.

هل يدعم QwQ-32B الإدخال متعدد الوسائط (Multimodal)؟

لا، النموذج يركز فقط على النصوص، دون القدرة على معالجة الصور أو الصوت مثل نماذج GPT-4o.

هل يمكن تعديل QwQ-32B ليتناسب مع مهامي؟

بالتأكيد، بما أنه «مفتوح الأوزان»، يتيح ذلك إمكانية تخصيصه وتدريبه بشكل دقيق لمهام محددة.

ويمكن الاستفادة من تقنيات مثل التخصيص الفعال للمعلمات (Parameter-efficient fine-tuning) لتقليل الموارد الحوسبية المطلوبة في هذه العملية.

هل يمكن تشغيل QwQ-32B على الأجهزة الشخصية؟

يعتمد الأمر على إمكانيات جهازك. فالنموذج يحقق أفضل أداء عند استخدامه مع وحدات معالجة رسومية متطورة مثل A100.

لكن، هناك حلول تقنية مثل «التكميم» يمكن أن تساعد في تشغيله على أجهزة بمواصفات أقل، مع احتمال وجود بعض التنازلات في مستوى الأداء.