هل يتفوق Llama-Nemotron 70B على GPT-4o وClaude؟ استخدمه مجانًا

أعلنت شركة Nvidia عن إطلاق نموذج Llama 3.1 Nemotrkon-70B في تعاون مثمر مع شركة Meta.

وهذا النموذج يمثل خطوة جديدة في المنافسة بين نماذج اللغات الكبرى، حيث تفوق أداؤه على منافسيه مثل GPT-4o وClaude 3.5 Sonnet في اختبارات الأداء والفعالية.

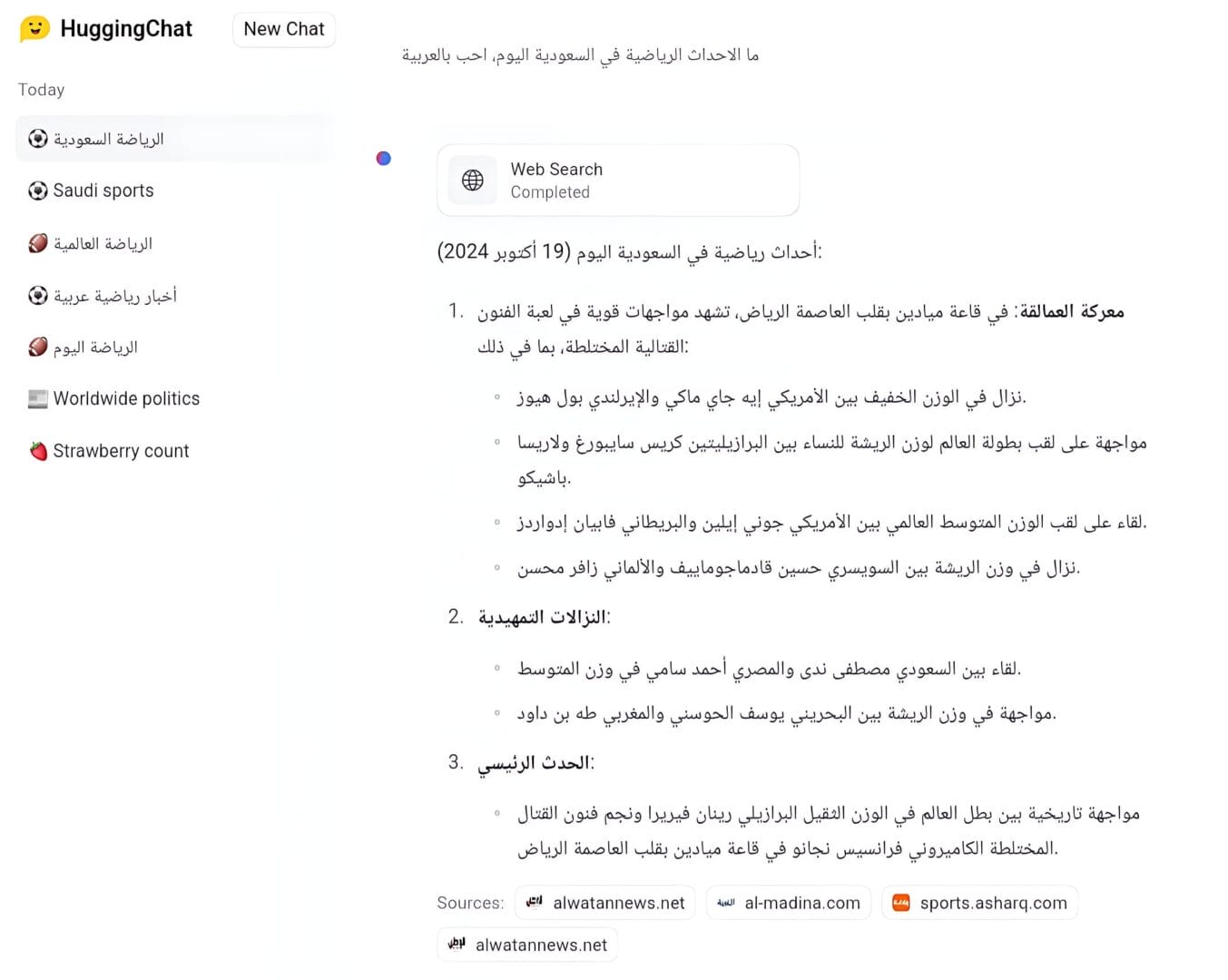

حيث قدم أداءً مميزًا في البحث عبر الإنترنت في الوقت الفعلي

مزايا Llama 3.1 Nemotron-70B

يعتمد هذا الإصدار على تقنية المحول (Transformer)، والتي تعتبر حجر الأساس في معالجة اللغات الطبيعية الحديثة.

ويأتي هذا الإصدار ببعض التحسينات، من أهمها:

١. يحتوى على 70 مليار معلمة، وهذا العدد الكبير يمنحه قدرة فائقة على إنتاج نصوص طبيعية وسلسة، فهي بمثابة المعرفة التي اكتسبها من البيانات.

٢. اهتمام متعدد الرؤوس (Multi-Head Attention)، لتمكينه من فهم السياق المعقد واستيعاب الاستفسارات المتشابكة.

فهذه التقنية تساعده في التركيز على أجزاء مختلفة من النص في نفس الوقت، مثلما يفعل الإنسان عندما يحاول فهم جملة معقدة.

على سبيل المثال، في جملة مثل «ذهبت إلى المتجر، لكنه كان مغلقًا».

فإن «الاهتمام متعدد الرؤوس» يساعد الأداة على التركيز على كلمتي «المتجر» و «مغلقًا» في نفس الوقت، لفهم أن المتجر هو الذي كان مغلقًا، وليس شيئًا آخر.

٣. تطبيع الطبقات (Layer Normalization)، لتحسين سرعة التعلم وتثبيت أداء النموذج أثناء التدريب.

فلو قلنا مثلًا أننا نقوم بتدريبه الآن على مهمة ترجمة النصوص، فأثناء هذه العملية يتعلم النموذج من خلال تعديل أوزانه الداخلية.

حيث تمثل هذه الاوزان أهمية كل كلمة أو جملة في عملية الترجمة، والتي أحيانًا تصبح كبيرة جدًا أو صغيرة جدًا.

وهو ما يتسبب في مشاكل مثل تباطؤ التعلم و عدم استقرار الأداء.

ولذلك يأتي دور تقنية تطبيع الطبقات لضبط قيم الأوزان أثناء التدريب، بحيث لا تتحول إلى أحجام كبيرة أو صغيرة جدًا.

وبالتالي تحسين سرعة وكفاءة عملية التعلم، وزيادة احتمالية الوصول إلى أداء أفضل.

كيف تدرب Llama-Nemotron

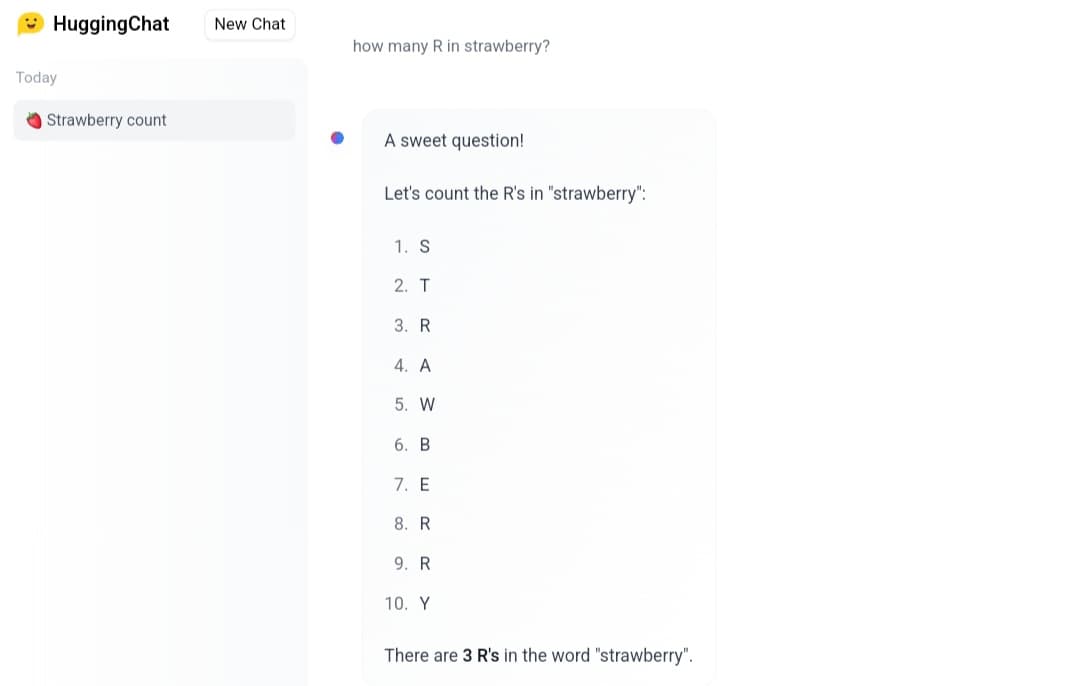

قبل الخوض في هذه الجزئية -واستعراضًا لقدرات Nemotron- وضعت انفيديا المطالبة المثيرة للجدل «كم عدد حرف R في Strawberry» كأحد الأمثلة المتاحة لتجربتها مباشرة على الأداة عبر صفحتهم في هاجنج فيس (الرابط بالأسفل).

وعند تجربتي لهذا السؤال، حصلت على الإجابة الصحيحة، وهذا ما يبين بعضًا من قدراته على التعامل بدقة مع التفاصيل اللغوية.

اعتمدت NVIDIA على مزيج من التعلم بالإشراف (Supervised learning) والتعلم المعزز من خلال التغذية الراجعة البشرية (RLHF) في تدريب Llama 3.1 Nemotron.

هذا النهج يسمح للنموذج ليس فقط بالتعلم من مجموعات بيانات ضخمة، بل أيضًا بضبط استجاباته لتناسب تفضيلات المستخدمين الفعلية.

و دعونا نوضح الأمر بشكل أوضح.

في التعلم بالإشراف يتم إدخال بيانات ضخمة للنموذج، وهذه البيانات تشمل المدخلات مع المخرجات الصحيحة.

مثلاً يتم تغذيته بنص (إدخال) مع ترجمته (إخراج)

أو كتاب (إدخال) مع تلخيصه (إخراج)

أي الشيء و نتيجته الصحيحة، لكي يفهم النموذج العملية الكاملة، و يتعلم كيفية ربط المدخلات بالمخرجات الصحيحة، وفهم العلاقات بين الكلمات والجمل، وبناء فهم عام للغة.

والآن انتهت المرحلة الاولى، حيث تعلم النموذج من هذه البيانات.

ومن هذه اللحظة، تأتي مرحلة «RLHF» لتحسين اداؤه بشكل أكبر، و ذلك من خلال الاستعانة بخبراء بشريين لتقييم ردوده على مجموعة من الأسئلة أو المهام.

مثل تقييم مدى دقة أو فائدة إجاباته على أسئلة معينة.

و بناءً على هذه التقييمات، يتم تعديل خوارزمياته لتعزيز السلوكيات التي تؤدي إلى ردود أفضل، وتقليل السلوكيات التي تؤدي إلى ردود غير مرغوب فيها.

و من خلال هذه المراحل السابقة، يتمكن النموذج من اكتساب معرفة واسعة، وتوليد ردود مناسبة، وتحسين دقته في أداء المهام اللغوية.

إذاً ما هي البيانات التي تم استخدامها في تدريبه؟

ج. تم تدريبه على بيانات متنوعة مرخصة بموجب CC-BY-4.0، والتي تشمل كتبًا ومقالات ومحتويات من الويب.

كيف تم تحسين ردود Llama-Nemotron؟

ج. اعتمدت NVIDIA على نماذج المكافآت، مثل Bradley Terry وSteerLM، لقياس جودة استجاباته من خلال تحليل تفاعل المستخدمين معها.

فمثلًا إذا أعجب المستخدمون برد معين منه، حينئذٍ سيتم اعتبار هذا الرد جيدًا، وبالتالي يتم تعديل خوارزمياته لزيادة احتمالية توليد ردود مشابهة في المستقبل.

وبهذه الطريقة، يتعلم النموذج من خلال هذا النوع من التفاعل، ويقوم بتحسين أدائه مع مرور الوقت.

مقارنة الأداء مع GPT-4o وClaude 3.5 Sonnet

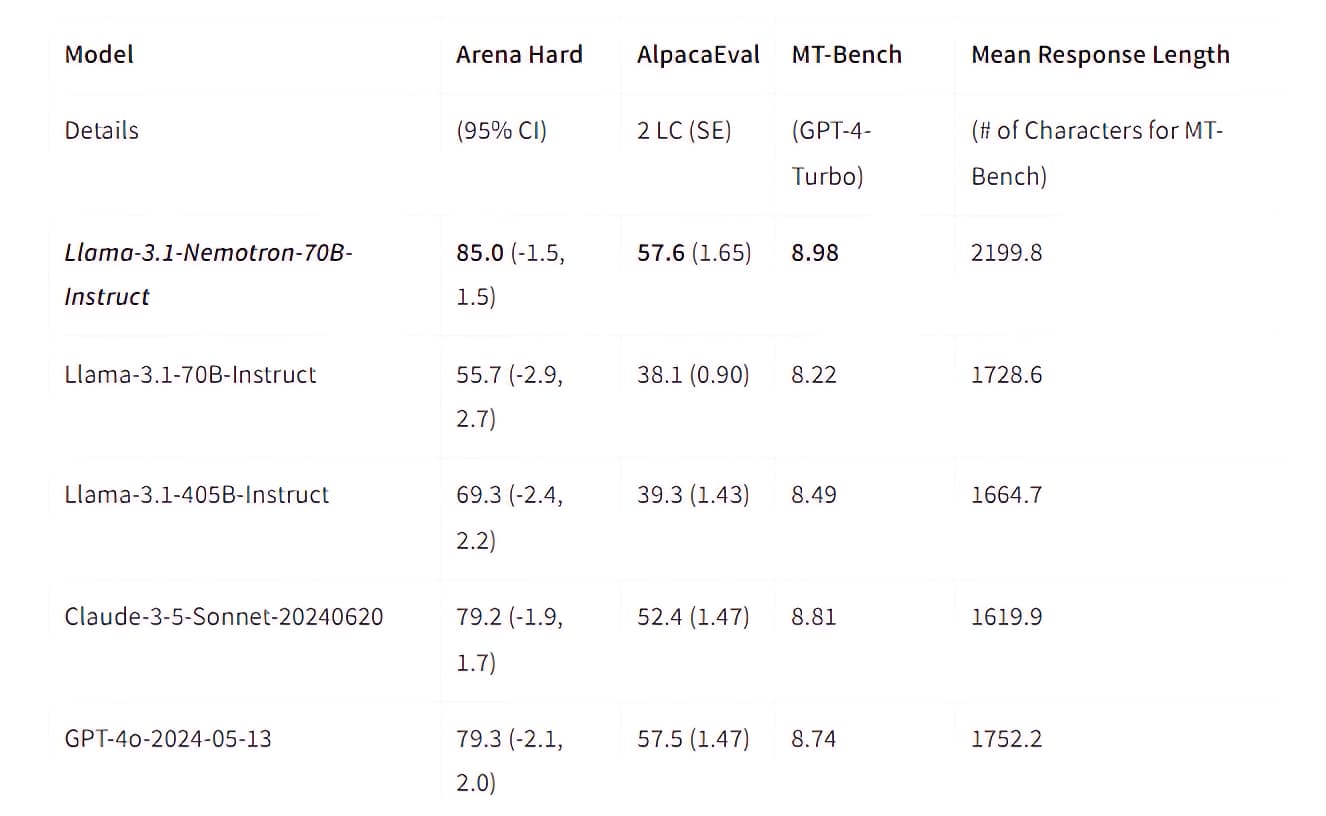

يوضح الجدول التالي الأداء العام لبعض نماذج الذكاء الاصطناعي المختلفة.

| النموذج | أداء التفكير المنطقي | أداء الدردشة | الأداء الكلي |

|---|---|---|---|

| Llama 3.1 Nemotron-70B | 98.1 | 97.5 | 94.1 |

| Skywork-Reward-Gemma-2-27B | 96.1 | 95.8 | 93.8 |

| TextEval-Llama3.1-70B | 96.4 | 94.1 | 93.5 |

| GPT-4o | 86.6 | 96.1 | 86.7 |

ومن خلال المقارنة، يظهر تفوق نموذج انفيديا بوضوح على منافسيه في أداء الدردشة والتفكير المنطقي.

و وفقًا لتحليلات Nividia في المعايير المختلفة، نلاحظ تفوق الإصدار الجديد في معيار Arena Hard، والذي يقيس قدرة النموذج على التعامل مع الأسئلة والمهام المعقدة.

فقد حقق نسبة 85 مقارنة ب 79 لكل من Claude-3.5 و GPT-4o، و 67 ل Llama-3.1-405B.

و من الاشياء الجيدة التي لاحظتها أيضًا هو متوسط طول الاستجابة (مدى تفصيل الردود) في Nemotron، حيث سجل 2199.8 حرفًا في المتوسط متجاوزًا الآخرين، وهو ما يجعلنا نأخذ منه استجابات غنية بالمعلومات ومفصلة.

كيفية الوصول المجاني إلى Llama 3.1 Nemotron-70B

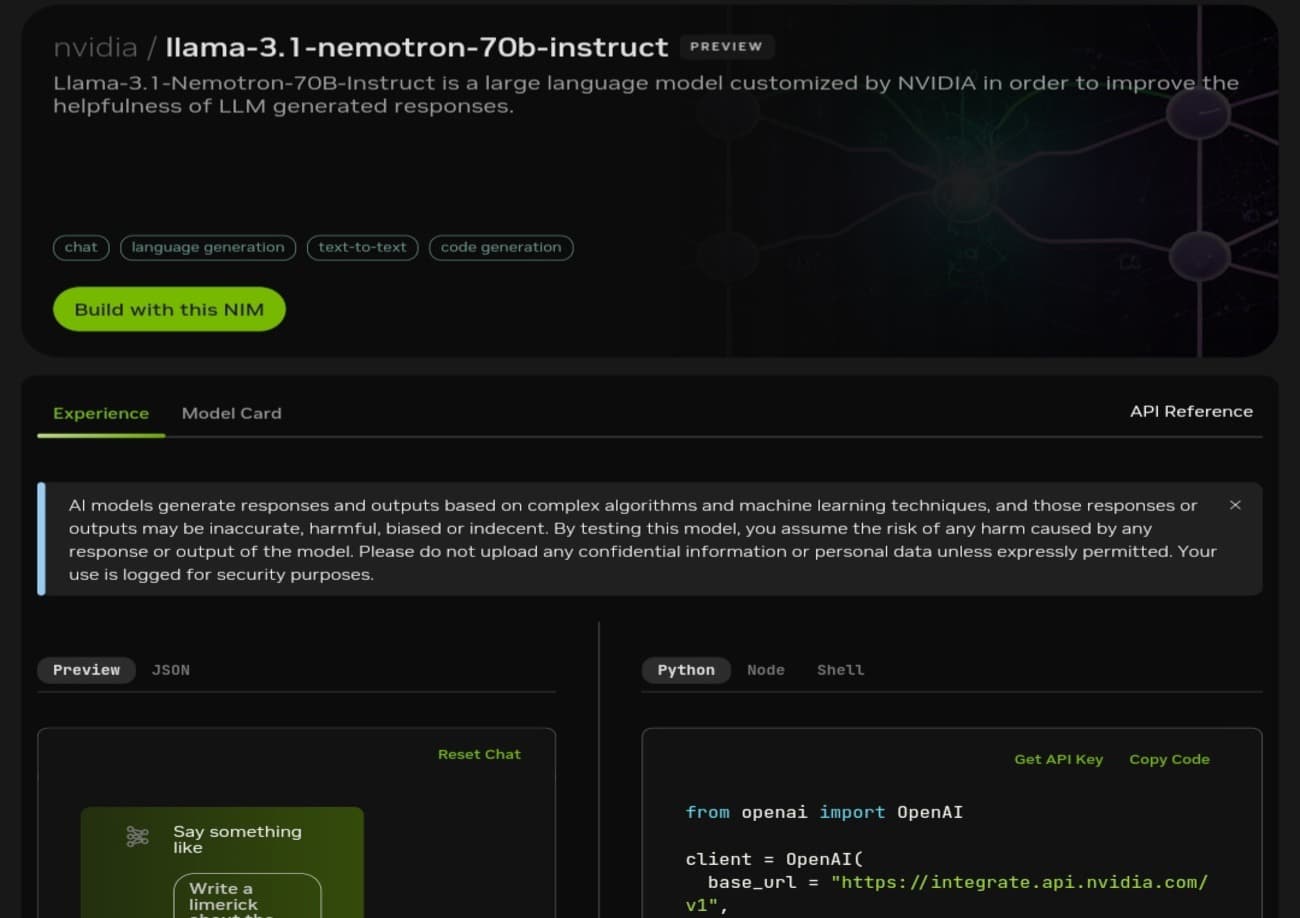

يتوفر النموذج للاستخدام المجاني عبر Hugging Face، مع إمكانية تفعيل خيار «Web search» للحصول على أحدث المعلومات.

كما يتوافر أيضًا على منصة NVIDIA ، والتي تقدم اشتراكًا مجانيًا يتضمن 100,000 مكالمة API، و هو ما يسمح لنا بتجربته بدون تكلفة.