Llama 3.3: نموذج ميتا الجديد لتحليل 400 صفحة من النصوص بكفاءة عالية

أعلنت شركة ميتا يوم الجمعة الماضي عن أحدث إصداراتها في مجال الذكاء الاصطناعي، وهو نموذج Llama 3.3 الذي يهدف إلى تحقيق التوازن بين الأداء العالي والتكلفة المنخفضة.

فمنذ اطلاقه، أثار هذا النموذج الجديد -الذي يعتمد على 70 مليار معلمة- الانتباه لقدرته على مجاراة نموذج ميتا الأضخم Llama 3.1 المكون من 405 مليار معلمة، مع تحقيق كفاءة تشغيلية أعلى وتكاليف أقل.

إن من أسباب هذه القوة بالأداء هو ما ذكره نائب رئيس الذكاء الاصطناعي التوليدي في ميتا، أحمد الدحلة بأن «لاما 3.3» يعتمد على تقنيات تحسين ما بعد التدريب التي تحسن الأداء بشكل ملحوظ دون الحاجة إلى موارد ضخمة.

Introducing Llama 3.3 – a new 70B model that delivers the performance of our 405B model but is easier & more cost-efficient to run. By leveraging the latest advancements in post-training techniques including online preference optimization, this model improves core performance at… pic.twitter.com/6oQ7b3Yuzc— Ahmad Al-Dahle (@Ahmad_Al_Dahle) December 6, 2024

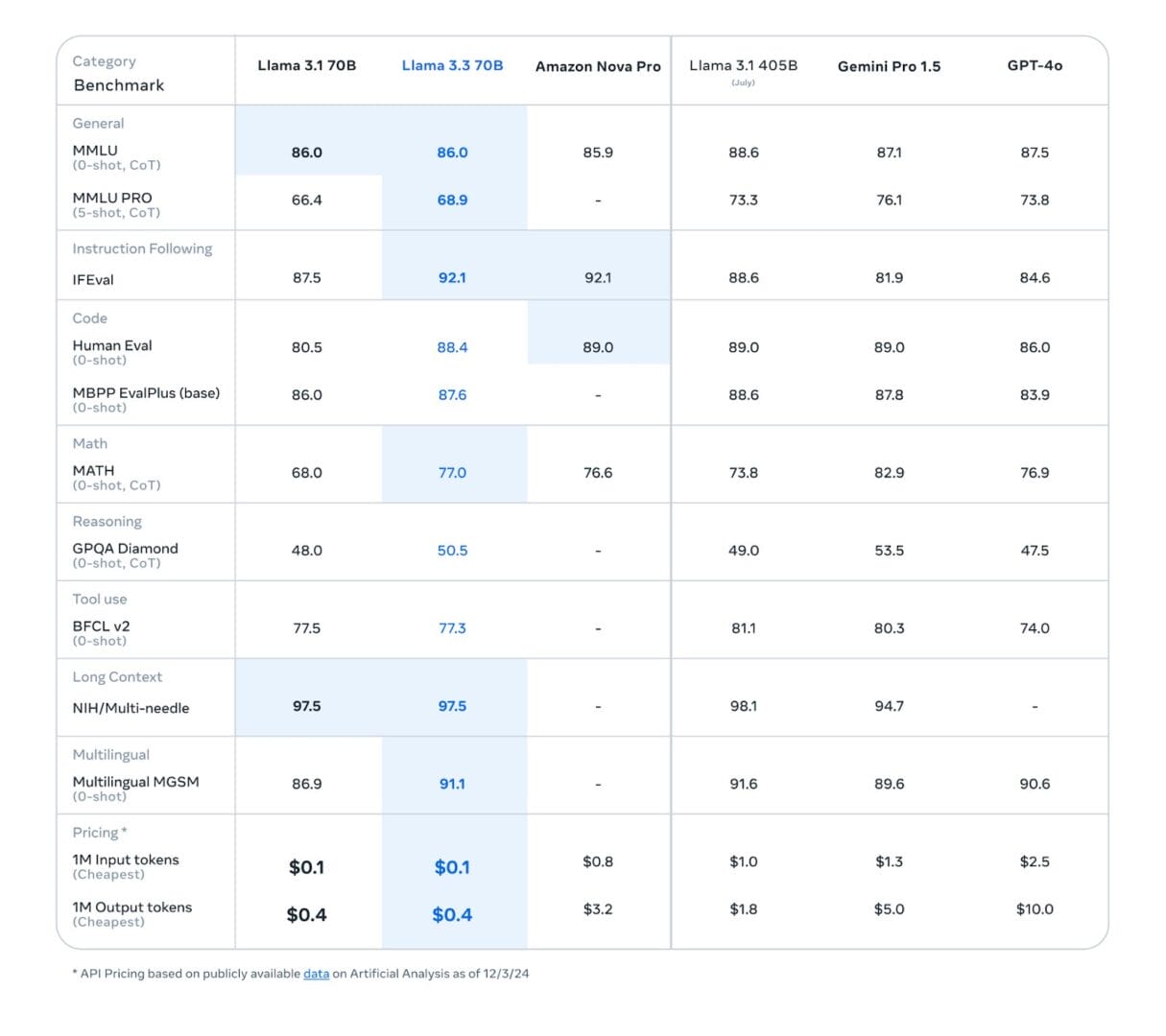

ولذلك نجد أن تكلفة تشغيله حوالي 0.1 دولار للإدخال و0.4 دولار للإخراج لكل مليون رمز، وهي أقل بشكل ملحوظ مقارنة بتكاليف تشغيل النماذج الأكبر حجمًا مثل «لاما 3.1″، والتي تصل إلى 1.0 دولار للإدخال و1.8 دولار للإخراج لكل مليون رمز.

وقد اعتمد النموذج على تقنيات جديدة مثل Grouped Query Attention (GQA) لتحسين الأداء والقدرة على التوسع أثناء الاستخدام. كما تم تطبيق تقنيات مثل التعليم المعزز Reinforcement Learning with Human Feedback (RLHF) لضمان التوافق مع تفضيلات المستخدمين وتقديم استجابات آمنة ومفيدة.

Llama-3.3-70B: نموذج مخصص للتطبيقات النصية

بخلاف نماذج الاصدار السابق 3.2 والتي لها قدرات على الرؤية ، يأتي Llama-3.3-70B بتركيز خاص على التطبيقات النصية، مستهدفا بذلك المشاريع التي تركز على الحوار، التعليم، وتحليل البيانات، خاصة مع دعمه للعديد من اللغات المختلفة.

ولم يفت الشركة أهمية جعل نموذجها قادرًا على التعامل مع المدخلات الطويلة، حيث يوفر النموذج نافذة سياق تصل إلى 128 ألف رمز، أي ما يعادل قراءة حوالي 400 صفحة من النصوص.

وبالنظر للاختبارات التي نشرتها ميتا، نجد ان Llama 3.3 70B قدم أداءً متميزاً في بعض الاختبارات المعيارية مثل القدرة على فهم المعلومات واستيعابها «MMLU PRO»، حيث حصل على درجات قاربت تلك التي حققها النموذج الأضخم Llama 3.1 405B.

ورغم تفوق 405B 3.1 في بعض المعايير، إلا أن إصدار الشركة الجديد أثبت كفاءة ملحوظة في مجالات أخرى، مثل الرياضيات والقدرة على الإجابة عن أسئلة معقدة. كما تميز بفهمه واستيعابه اللغات المتعددة بشكل أفضل متفوقا على «GPT-4o» من «OpenAI» و»Gemini 1.5 Pro»، بينما يتألق النموذجان الآخران في جوانب أخرى مثل الاستدلال المنطقي وإنشاء نصوص إبداعية ومعالجة التعليمات المعقدة.

تنزيل Llama 3.3، والاستخدام المجاني

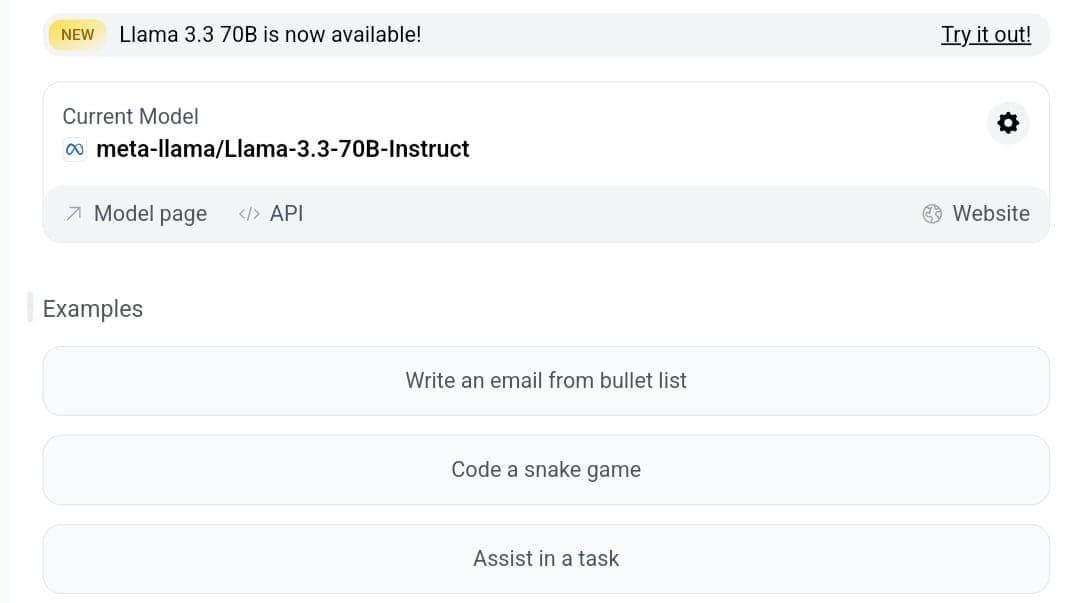

يتوافر النموذج للتنزيل من منصات مثل Hugging Face والموقع الرسمي (llama.com)، في ظل استراتيجية ميتا في تقديم نماذج «مفتوحة» تُستخدم في العديد من التطبيقات التجارية.

ومع ذلك، وضعت الشركة قيودًا على المنصات التي تضم أكثر من 700 مليون مستخدم شهريًا، حيث يتعين عليها طلب تراخيص خاصة. رغم ذلك، سجلت سلسلة Llama أكثر من 650 مليون عملية تنزيل، مما يعكس شعبيتها الكبيرة بين المطورين.

وعلى جانب الأفراد ممن يريدون تجربة الإصدار الجديد، فالروبوت متوافر حاليًا للاستخدام المجاني على منصة HuggingChat.

وقد استخدمت ميتا النموذج داخليًا أيضًا في تطوير مساعد الذكاء الاصطناعي الخاص بها، Meta AI، الذي يجذب قرابة 600 مليون مستخدم نشط شهريًا، حسب تصريحات مارك زوكربيرغ، والذي زعم أيضًا أن Meta AI في طريقه ليصبح المساعد الأكثر استخدامًا عالميًا.

وعلى الجانب التقني، أعلنت «Meta» عن بناء مركز بيانات بقيمة 10 مليارات دولار في ولاية لويزيانا، وتأتي هذه الخطوة ضمن استراتيجية طويلة المدى تهدف إلى إطلاق «لاما 4» بحلول عام 2025، والذي يتطلب موارد أكبر بعشر مرات مما كان يحتاجه الجيل الحالي. وفي إطار ذلك، استحوذت ميتا على أكثر من 100,000 وحدة معالجة رسومات (GPU) من شركة Nvidia، لمواكبة منافسين مثل xAI.