جرب مجانًا سرعة ردود قياسية من Llama 3.1 باستخدام أفضل المعالجات

في ظل المنافسة الكبيرة نحو تطوير حلول لتحقيق أعلى سرعة في معالجة نماذج اللغة الكبيرة (LLMs)، برزت شركتان ناشئتان يقدمان تطورات كبيرة في هذا المجال، و هما Cerebras Systems و SambaNova.

الشركتان أطلقتا مؤخراً خدمات استنتاج و معالجة هي الأسرع على الإطلاق.

بمعنى آخر، تُقدمان أفضل الطرق لاستخدام نماذج اللغة للحصول على معلومات بكفاءة في وقت أقل. مع تحقيق أرقام قياسية سنتعرف عليها بالمقال.

● و لكن قبل أن نبدأ، علينا معرفة ما تتفوق به كل شركة لكي تتضح الأمور.

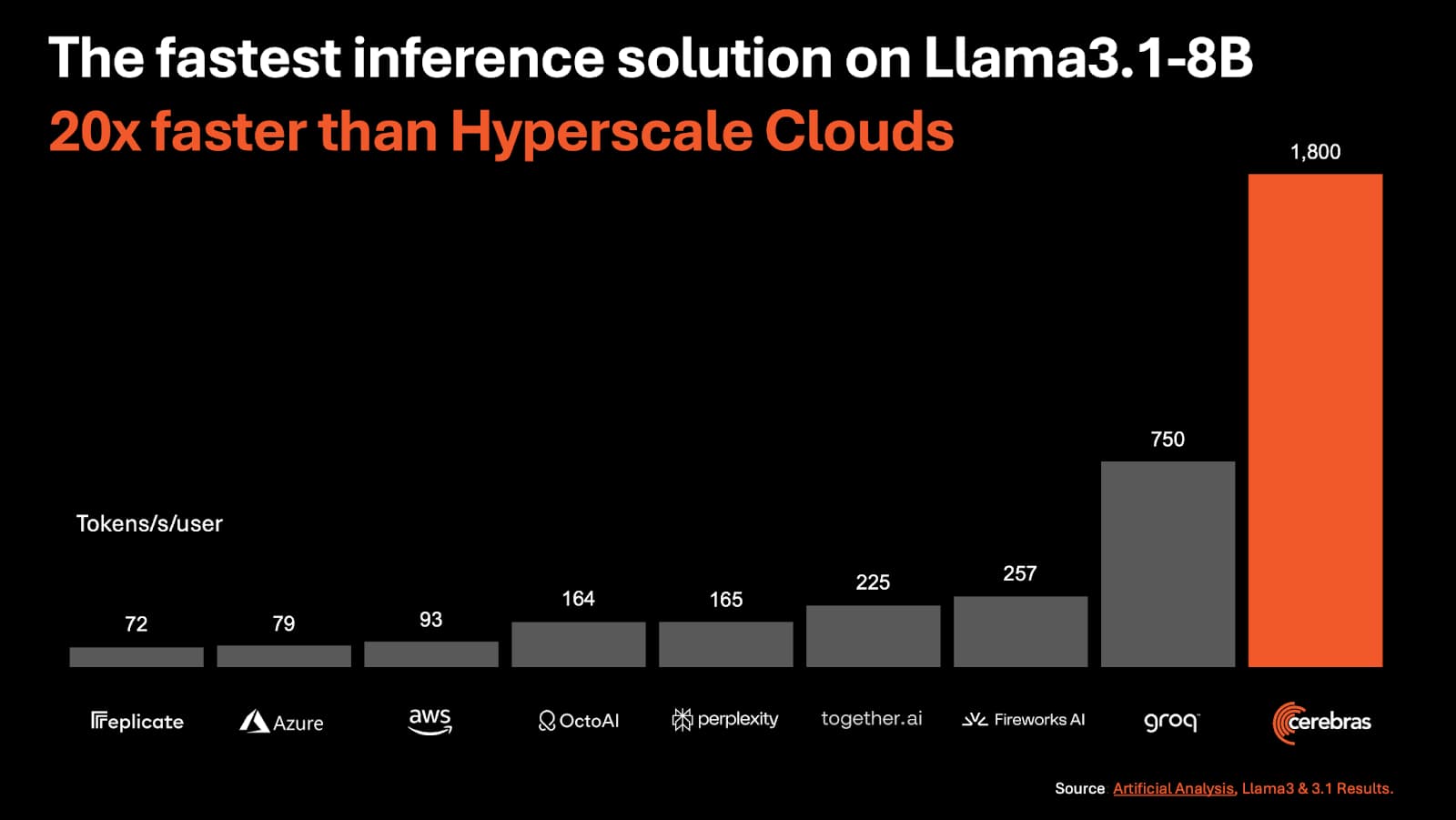

تُركز Cerebras على زيادة سرعة استجابة نماذج اللغة، مثل ChatGPT، لتكون أسرع في تقديم الإجابات. و قد حققت رقما قياسيا في باستخدام نماذج Llama 3.1 70B & 8B.

بينما تركيز SambaNova على تحقيق توازن بين السرعة والكفاءة، وقد أثبتت ذلك بتحقيقها رقمًا قياسيًا في سرعة استجابة نموذج Llama 3.1 405B الضخم مع الحفاظ على دقة عالية.

Cerebras تُقدم أسرع محرك استنتاج في العالم

هل تخيلت يومًا أن تمتلك جهاز كمبيوتر قادرًا على معالجة المعلومات بسرعة تفوق أسرع وحدات معالجة الرسومات الحالية بعشر مرات؟ هذا ليس خيالًا علميًا، بل هو واقعٌ تُقدمه شركة Cerebras Systems بفضل تقنيتها الثورية. يُشير James Wang، أحد خبراء التكنولوجيا، إلى أن هذا التقدم يعادل عشر سنوات من التطور التكنولوجي، مُضيفًا: «متى حدث هذا من قبل في عالم التكنولوجيا؟»

Cerebras is 10x faster than GPUs

10x = 3 Moore’s Law doublings = 10 years

It’s basically like getting a GPU from 2034.

When has this ever happened in tech? pic.twitter.com/cuu3Av4jIV— James Wang (@draecomino) August 27, 2024

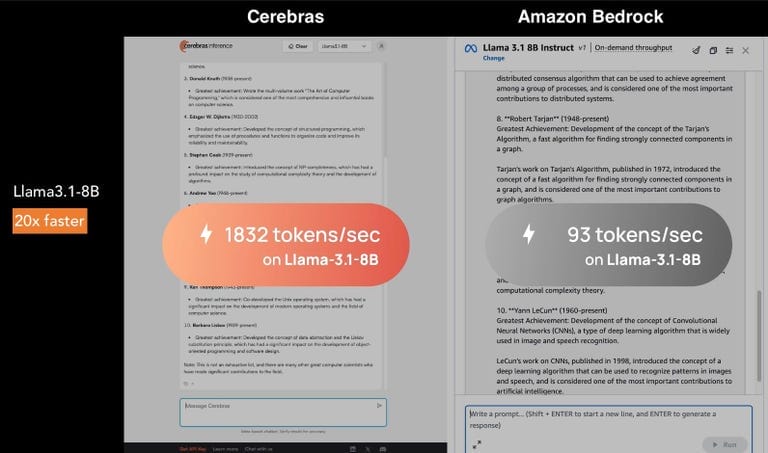

قدمت Cerebras Systems رقمًا قياسيًا باستنتاج:

450 رمزًا في الثانية لنموذج Llama 3.1-70B

و 1832 رمزًا في الثانية لنموذج Llama-3.1 8B

حيث أعلنت هذه الشركة عن إطلاق تقنية جديدة تُسمى Cerebras Inference.

تأتي هذه التقنية كواحدة من أسرع حلول استنتاج نماذج اللغة الكبيرة (LLMs) في العالم حاليًا.

و تُعد حلاً متطورًا لمعالجة نماذج اللغة الكبيرة، حيث تحقق سرعة استنتاج تفوق الحلول التقليدية بمقدار 20 مرة.

ووفقًا للاختبارات، فإن Inference يمكنها استنتاج 450 رمزًا في الثانية لنموذج Llama 3.1-70B، وهو معدل يتفوق حتى على أكثر تقنيات وحدات معالجة الرسومات (GPUs) تطورًا.

ما الذي يجعل هذه تقنية Inference مميزة؟

السر وراء هذه السرعة الفائقة هو استخدام شريحة سيليكون ضخمة تُسمى Wafer Scale Engine (WSE). هذه التقنية تعتمد على شريحة سيليكون كبيرة جدًا تُعد الأكبر من نوعها في العالم.

حيث تقوم بتخزين النموذج بالكامل على الشريحة دون الحاجة لنقل البيانات، مما يقلل من زمن نقل البيانات و المعالجة.

وبالتالي هذا يزيد من كفاءة عملية استنتاج النتائج.

كما تمتلك هذه الشريحة ذاكرة متطورة تُساعد على الوصول إلى البيانات بسرعة كبيرة جدًا، مما يجعل الأداء الإجمالي أكثر كفاءة.

تتفوق «Inference» على الأنظمة المنافسة مثل تلك التي تعتمد على وحدة معالجة الرسومات «H100» من «Nvidia» بمعدل يصل إلى عشرين ضعفاً في السرعة.

ولإثبات سرعة هذه الخدمة، أجرت «Cerebras Systems» تجربة عملية أمام الصحافة، حيث تم تشغيل نفس الطلبات باستخدام نموذج Llama 3.1 8b على منصات مختلفة، من بينها «AWS» من «أمازون».

المصدر: ZDNet

فبينما كانت منصات أخرى تتأخر في تقديم النتائج، نجحت «Cerebras» في معالجة الطلب بمعدل مذهل بلغ 1832 رمزاً في الثانية.

ليس هذا فحسب، فالأمر الآخر الذي أراه ممتازًا هو أن Cerebras Inference تقدم تكلفة أقل بخمس مرات من حلول hyperscale السحابية، مما يجعلها خيارًا جذابًا للشركات التي تسعى إلى خفض التكاليف دون التضحية بالأداء.

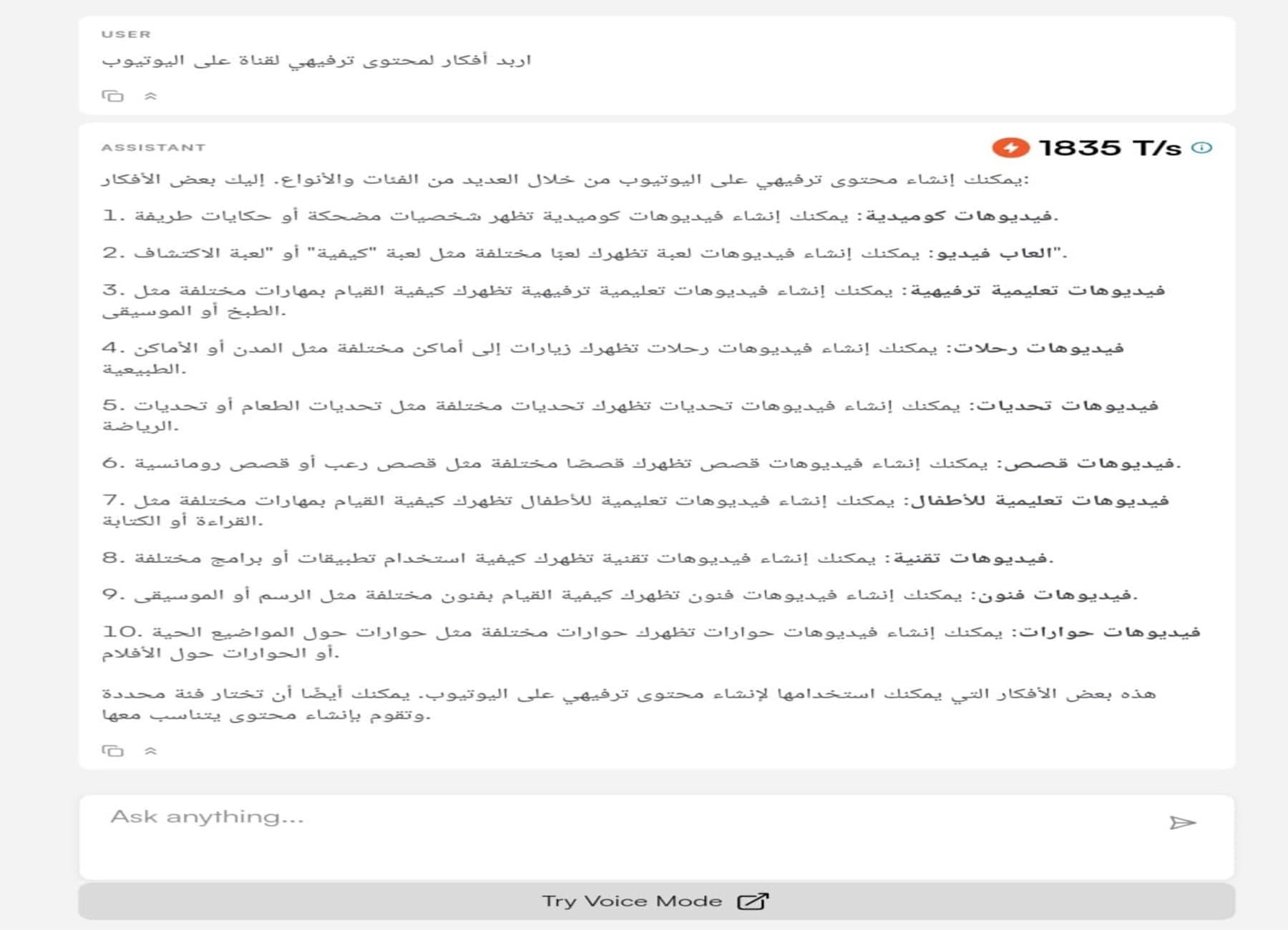

التجربة الشخصية لنموذج Llama-3.1 8B باستخدام Cerebras

توفر لك الشركة عبر موقعها نموذج لاما ٨ب للاستخدام المجاني، لذا قررت تجربة هذا الإصدار و تقييم كفاءته.

بدأت بالطلب من النموذج أن يعطيني أفكار عن محتوى ترفيهمي لقناة يوتيوب تهتم بمجال الديكور، و استجاب في وقت قياسي بمعدل أكبر من 1835 رمز الثانية الواحدة.

الاستخدام المجاني

استمتع بتجربة الخدمة مجانًا على موقع Cerebras

SambaNova Systems تحطم الأرقام القياسية في سرعة استنتاج الإصدار الأضخم من Llama

معالجة نموذج «Llama 3.1 405B» بمعدل 114 رمزاً في الثانية الواحدة

و بينما تواصل «Cerebras Systems» تحطيم الأرقام القياسية في مجال الاستنتاج، تبرز «SambaNova» كشركة منافسة أيضًا بقوة.

حيث أعلنت عن تحقيق إنجاز جديد يتمثل في تسجيل سرعة غير مسبوقة في معالجة نموذج «Llama 3.1 405B» من «Meta»، بمعدل 114 رمزاً في الثانية.

هذا الأداء المتفوق -الذي تم التحقق منه من قبل «Artificial Analysis»- يجعل «SambaNova» تتفوق بأكثر من أربعة أضعاف على المزودين الآخرين.

مما يثبت قدرة هذه الشركة على التعامل مع نماذج الذكاء الاصطناعي الضخمة بفعالية عالية.

SambaNova is serving Llama 3.1 405B at 114 output tokens/s with their custom chips! This is the fastest we have benchmarked and 4X faster than the median of providers on Artificial Analysis.

Larger models with higher quality come at the cost of speed. New AI-focused custom… pic.twitter.com/6Oqozxwh0I— Artificial Analysis (@ArtificialAnlys) July 29, 2024

كيف تُحقق SambaNova هذه السرعة المُذهلة في معالجة نماذج اللغة؟

الفضل في هذا الإنجاز يعود إلى شريحة SN40L RDU، و هي شريحة من الجيل الرابع مخصصة لتسريع تدريب نماذج الذكاء الاصطناعي، و تعمل على:

- تحسين حركة البيانات، حيث تُقلل SN40L RDU من زمن الوصول إلى البيانات و تُحسّن كفاءة نقلها بين مُختلف مكونات النظام.

- معالجة نماذج LLM بدقة 16 بت دون التضحية بدقة النموذج، مما يُساهم في زيادة أداء المعالجة.

هذا الإنجاز يفتح الباب أمام استخدامات جديدة في مجالات مثل معالجة الوثائق الذكية، حيث تلعب السرعة دوراً حاسماً في تحقيق أداء أفضل.

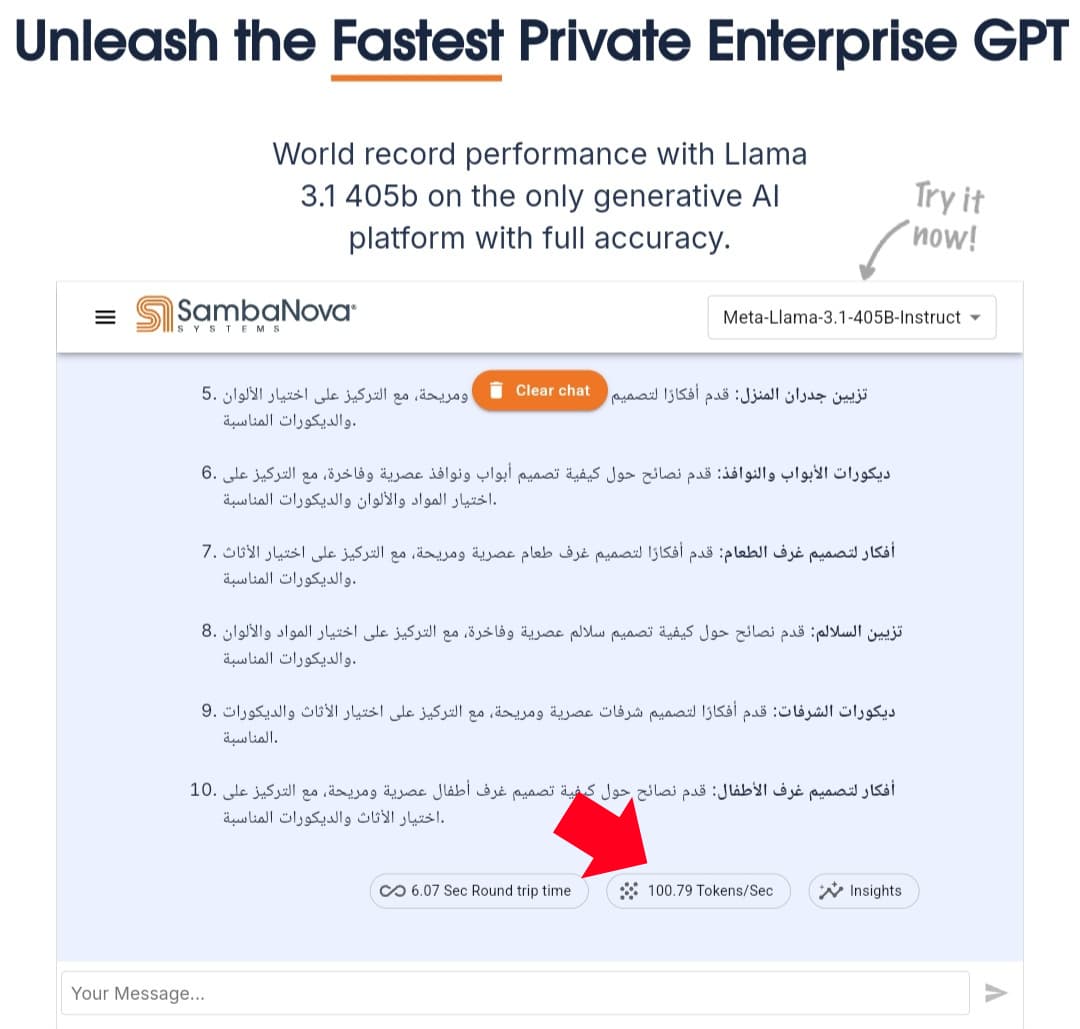

التجربة الشخصية لنموذج Llama-3.1 405B باستخدام SambaNova

توفر لك الشركة عبر موقعها نموذج لاما بمختلف إصداراته، لذا قررت استخدام الاصدار الأكبر 405B و الذي حققت فيه الشركة الرقم القياسي.

بدأت بسؤال لاما أن يعطيني أفكار عن محتوى لقناة يوتيوب تهتم بمجال الديكور.

و كان على الموعد بأداء رائع، حيث استجاب بمعدل أكبر من 100 رمز الثانية الواحدة.

الاستخدام المجاني

استمتع بتجربة مجانية على موقع SambaNova

بالختام، تعتبر Cerebras و SambaNova من الشركات القادمة بقوة في تطوير حلول مُبتكرة لمعالجة نماذج اللغة الكبيرة.

تُركز كلتا الشركتين على زيادة سرعة استجابة هذه النماذج، لكن بطرق مُختلفة.

حيث تتميز Cerebras بتقديمها أسرع مُحرك استنتاج في العالم.

بينما تُقدم SambaNova حلاً شاملاً يعمل على زيادة سرعة و كفاءة مُختلف جوانب معالجة LLMs.

ومن خلال توفير فعالية و كفاءة غير مسبوقة في معالجة LLMs، تساعد الشركتان في تطوير تطبيقات ذكاء اصطناعي أكثر قوة و فعالية.

وبالتالي علينا أن نتفائل بمستقبل واعد لتطبيقات الذكاء الاصطناعي في جميع المجالات.