الذكاء الاصطناعي بالعربية | Arab AI - الموقع الرائد للذكاء الاصطناعي بالعربي

كل ما تحتاج معرفته عن GPT-5.2: هل يستحق الترقية من ChatGPT المجاني؟

انطباعات أولى تنقسم بين قوتين متضادتين عندما أعلنت أوبن أيه آي… ...

المحتوى المميز

اكتشف أحدث وأهم المقالات والأدوات في مجال الذكاء الاصطناعي.

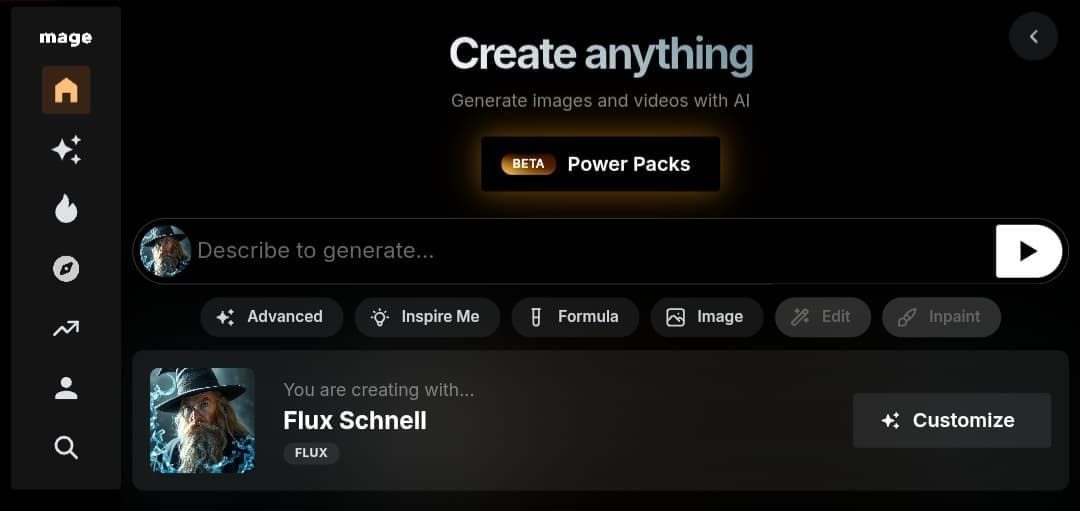

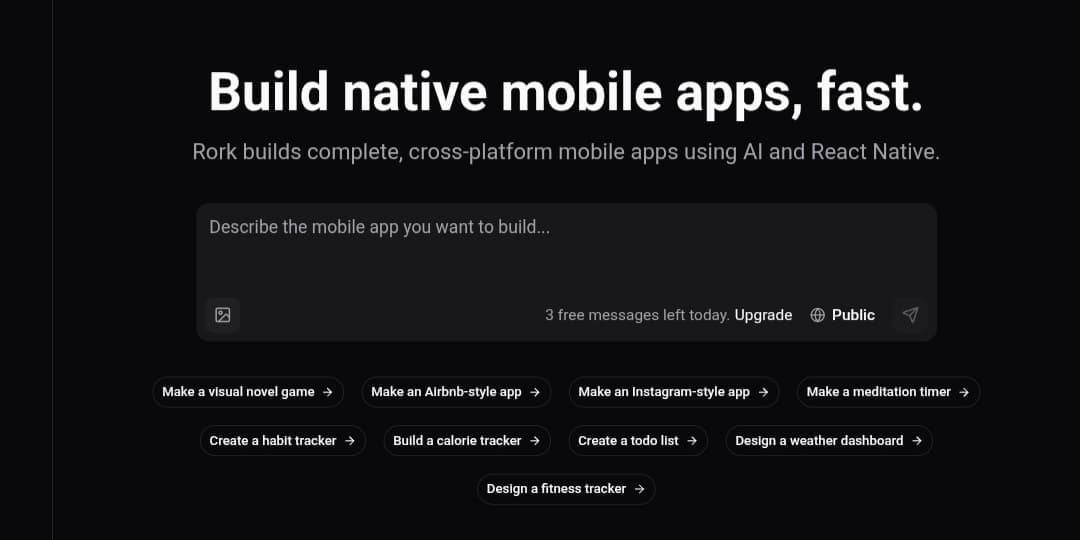

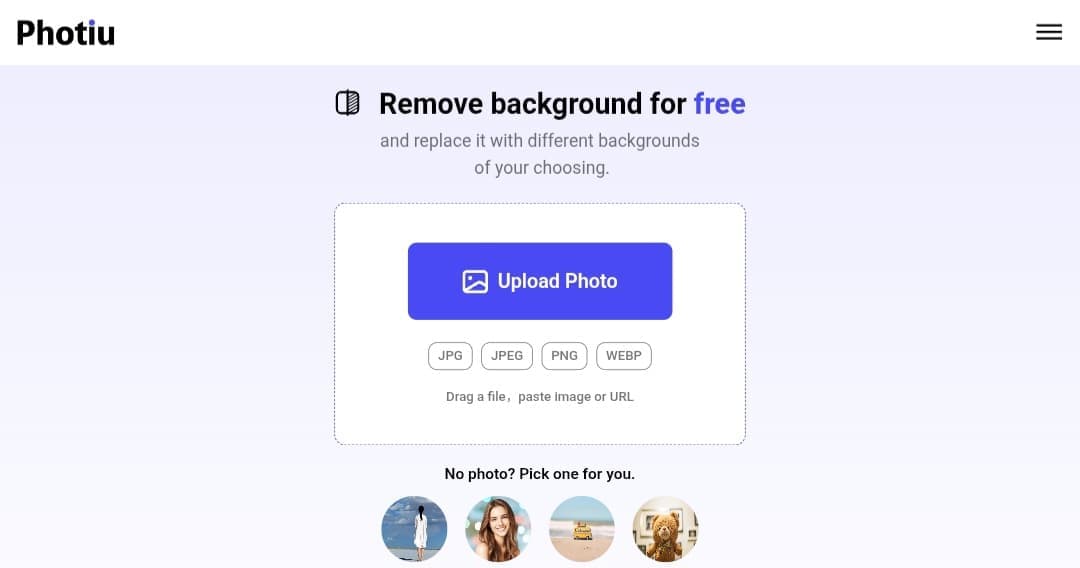

أحدث المحتوى

تابع أحدث المقالات والأدوات والتطبيقات في مجال الذكاء الاصطناعي.

نحن مجموعة من المهتمين بتكنولوجيا الذكاء الاصطناعي، نسعى لتقديم أحدث المعلومات والأخبار حول الابتكارات والتطورات في هذا المجال. نهدف موقعنا إلى تمكين المجتمع العربي من فهم التقنيات الذكية واستخدامها بشكل فعال في مختلف المجالات. من خلال تقديم محتوى شامل، سواء كان مقالات، أخبار، أو أفضل التطبيقات، نحن نؤمن بأن المعرفة هي المفتاح للمستقبل. نعمل على تقديم موارد سهلة الفهم ومفيدة للمبتدئين والمحترفين على حد سواء. نحن هنا لنساعدكم على استكشاف هذا العالم وتطبيقاته في حياتكم اليومية. انضموا إلينا في هذه الرحلة المثيرة واكتشفوا كيف يمكن لهذه التقنيات أن تغير العالم العربي.