نموذج OpenAI O1 يثير الجدل: لماذا يفكر بالصينية أثناء الإجابة؟

ظهر مؤخرًا سلوك غريب في النموذج o1 -أول نموذج «منطقي» طورته OpenAI- وفقًا لما أشار له تقرير موقع «تك كرانش» التقني.

فقد لاحظ المستخدمون أنه يشرع في «التفكير» أحيانًا بلغات مثل الصينية أو الفارسية أثناء معالجته أسئلة مكتوبة باللغة الإنجليزية.

فعلى سبيل المثال، عند طرح سؤال بسيط مثل «كم عدد الحروف R في كلمة ‘strawberry’؟«، يبدأ o1 سلسلة من الخطوات المنطقية للإجابة، لكنه يتخلل هذه الخطوات بلغات أخرى قبل تقديم الرد النهائي باللغة الإنجليزية.

فرضيات متداولة

رغم غياب توضيح رسمي من OpenAI حول هذه الظاهرة، فإن الخبراء لديهم تفسيرات محتملة.

1. تأثير البيانات التدريبية

تتمثل إحدى النظريات الرئيسية في أن النماذج مثل o1 تتأثر بالبيانات المستخدمة أثناء تدريبها.

على سبيل المثال، يتم تدريب العديد من النماذج على مجموعات بيانات ضخمة تحتوي على نصوص بلغات متعددة، بما في ذلك الصينية. وهذا يجعل النموذج يميل أحيانًا إلى الاستفادة من هذه اللغات في بعض المواقف.

ويشير باحثون في شركات مثل DeepMind إلى أن السبب قد يكون أيضًا الاعتماد على خدمات تصنيف البيانات الخارجية، خاصة تلك التي تتواجد في الصين.

وتضيف هذه الخدمات تسميات (Labels) للنصوص لتساعد النموذج على فهم الأنماط. إذا كانت عملية التصنيف متأثرة باللغة الصينية، فقد ينعكس ذلك على أداء النموذج.

2. الكفاءة اللغوية

بينما تفترض نظرية أخرى أن النموذج يختار اللغة التي يراها أكثر كفاءة في سياق معين.

على سبيل المثال، اللغة الصينية تتسم باختصار الكلمات، ما يجعلها مفيدة في المهام الرياضية أو المنطقية.

وقد تكون هذه الميزة هي السبب وراء استخدام الروبوت لهذه اللغة أثناء حل مسائل معينة.

3. النماذج كأنظمة احتمالية

النماذج مثل o1 لا تفهم اللغات كما يفهمها البشر.

بدلاً من ذلك، تعالج النصوص على شكل رموز (Tokens). هذه الرموز يمكن أن تكون كلمات أو مقاطع أو حتى أحرف منفردة.

وقد يتعلم النموذج أثناء التدريب أن بعض الأنماط في لغة معينة أكثر فعالية للوصول إلى الإجابة.

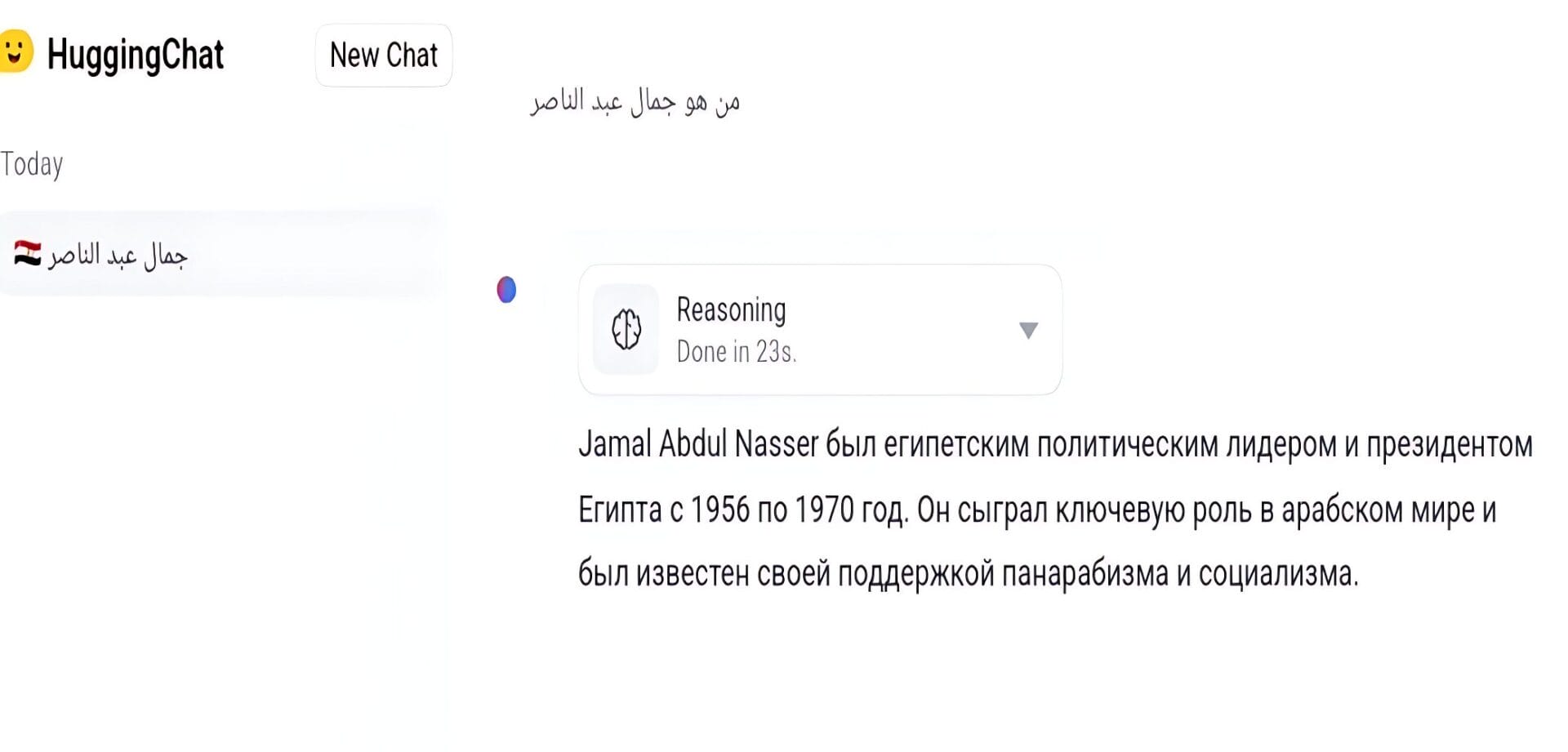

هذا ما حدث مع نموذج التفكير QwQ-32B-Preview من علي بابا، عندما سألته بالعربية عن رئيس مصر في الستينيات: «من هو جمال عبد الناصر؟»، حيث أجاب بالروسية مختلطة بالإنجليزية.

4. العشوائية والسلوك غير المتوقع

بما أن النماذج تعتمد على الاحتمالات، فإن سلوكها أحيانًا يكون غير متوقع.

وقد يختار الروبوت استخدام لغة معينة بدون سبب واضح، أو بسبب الهلوسة والتي تختلف درجتها من نموذج لآخر.

ولكن حتى الآن، يظل سلوك «التفكير متعدد اللغات» لغزًا.

ولا يمكننا التأكد من الأسباب بدقة بسبب طبيعة النماذج التي تعتبر معقدة وغير شفافة.

وفي هذا السياق، يؤكد الباحثون مثل Luca Soldaini على أهمية الشفافية في بناء هذه الأنظمة لفهم أفضل لكيفية عملها.

بالختام، فإن هذه الظاهرة تلقي الضوء على تحديات أوسع في تصميم نماذج الذكاء الاصطناعي، مثل تأثير البيانات التدريبية والتحيزات المحتملة. ولذلك تزداد الحاجة إلى مراقبة دقيقة للنماذج لضمان أداء أكثر اتساقًا وشفافية.