OpenAI تعلن عن نماذج صوتية جديدة بقدرات تحكم متقدمة في طريقة الكلام

كشفت شركة OpenAI عن جيل جديد من النماذج الصوتية التي تتيح للمطورين التحكم الكامل في طريقة حديث المساعدات الصوتية، عبر أوامر نصية بسيطة، مع تحسين كبير في دقة تحويل الكلام إلى نص حتى في أصعب الظروف الصوتية.

نماذج تحويل الصوت إلى كتابة

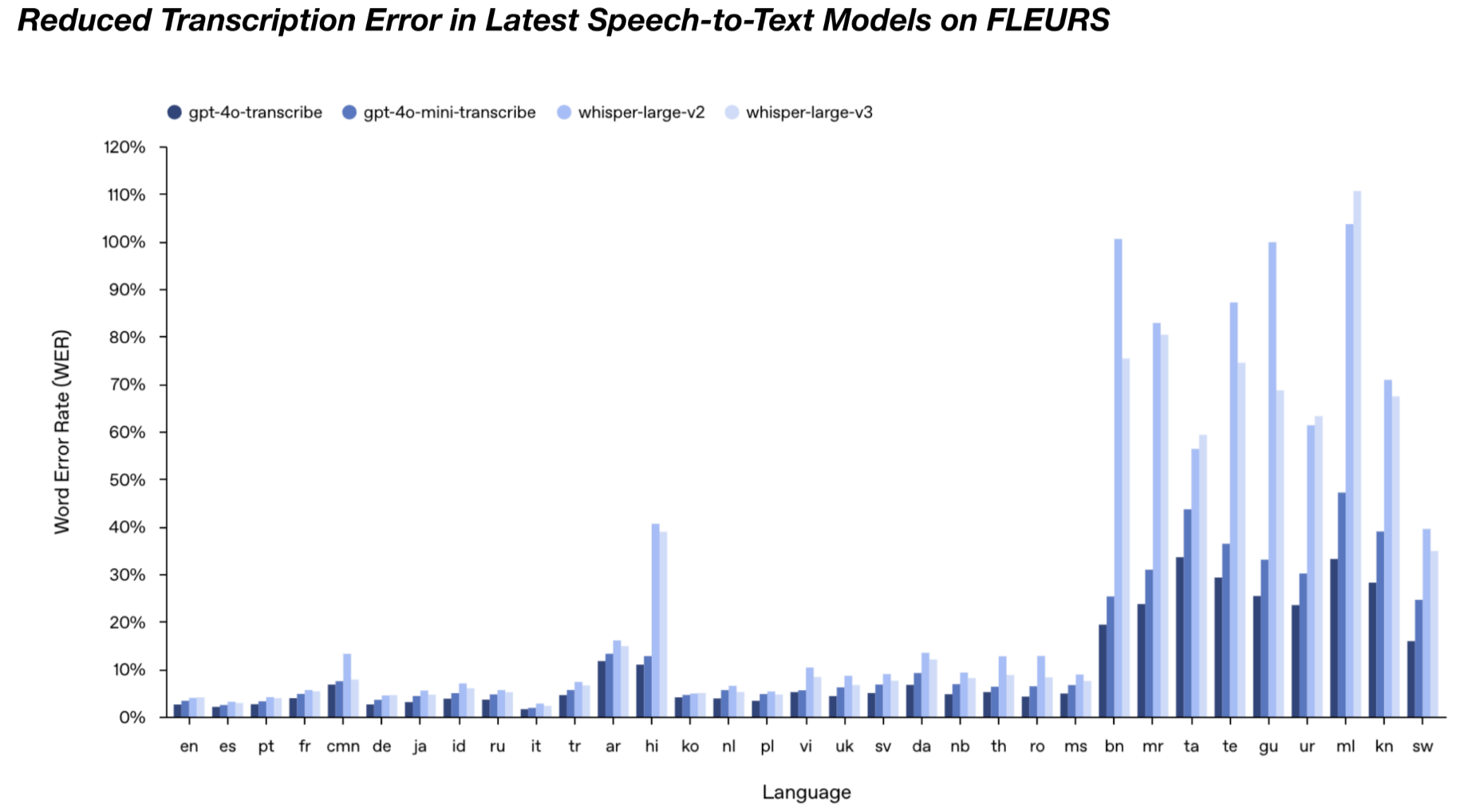

أعلنت الشركة عن نموذجين محسّنين لتحويل الكلام إلى نص هما gpt-4o-transcribe وgpt-4o-mini-transcribe.

وقد أثبتا تفوقًا واضحًا على النماذج السابقة من Whisper، خصوصًا عند التعامل مع لهجات متنوعة أو معقدة، أو بيئات صاخبة أو تغيرات سريعة في سرعة الكلام.

وأفادت OpenAI أن هذه النماذج قادرة على تقليل نسبة الخطأ بفضل تدريبها على بيانات صوتية متنوعة وعالية الجودة.

هذا إلى جانب استخدام تقنيات دقيقة في تقليص حجم النماذج، مع تطبيق التعلم المعزز لتحسين قدرتها على فهم الكلام بدقة.

gpt-4o-mini-tts: تحويل النصوص إلى أصوات

على جانب آخر، قدمت الشركة نموذج gpt-4o-mini-tts لتحويل النصوص إلى كلام بشري، ويمتاز بإمكانية «توجيه» الصوت وفق أوامر نصية تحدد أسلوب الحديث المطلوب.

فعلى سبيل المثال، يستطيع المطور أن يطلب من النموذج «التحدث بصوت قرصان» أو «سرد القصة بصوت يشبه الحكايات الليلية»، ويقوم النموذج بتنفيذ ذلك بدقة.

وصرح جيف هاريس، أحد أعضاء فريق المنتج في OpenAI، لموقع تك كرانش التقني بأن الهدف من هذه التقنية هو تمكين المستخدم من التحكم ليس فقط في المحتوى الذي يُقال، بل أيضًا في كيفية إلقائه، وفق السياق الذي يتطلب نبرة صوتية محددة مثل الأسف أو الهدوء أو الحماس.

تحسينات ملحوظة، وقيود حالية

أوضحت OpenAI أن النماذج الصوتية الجديدة تعتمد على بنية GPT-4o وGPT-4o-mini، التي تتيح التعامل مع أنواع متعددة من الوسائط، من بينها النص والصوت والصورة.

ومن أبرز التحسينات التي قدمتها هذه الأدوات هو قدرتها على تجاوز مشكلة «الهلوسة».

وهي المشكلة التي كانت تؤثر على Whisper سابقًا، حيث كانت تضيف كلمات غير موجودة في التسجيل الأصلي.

وبفضل التدريبات الموسعة على بيانات صوتية متنوعة، أصبحت النماذج الجديدة أكثر دقة في التقاط الكلام كما هو دون تحريف.

ورغم ذلك، تظل دقة gpt-4o-transcribe محدودة عند التعامل مع بعض اللغات مثل التاميل والتيلوغو والمالايالام والكانادا، حيث تصل نسبة الخطأ إلى نحو 30%.

أي أن النموذج قد لا يلتقط نحو 3 كلمات من كل 10 كلمات عند تحويل هذه اللغات إلى نص.

من ناحية أخرى، أكدت OpenAI أن النماذج الحالية تقتصر على استخدام أصوات محددة مسبقًا، ولا يمكن في الوقت الراهن توليد أصوات جديدة أو نسخ أصوات قائمة.

إلا أن الشركة تخطط لإتاحة هذه الإمكانية مستقبلًا، ضمن معايير أمان مشددة.

كما تسعى إلى توسيع نطاق الاستخدام ليشمل الفيديو، ضمن توجهها نحو تقديم تجارب متعددة الوسائط.

الوصول إلى النماذج الصوتية الجديدة، والحدود

يمكن للمطورين الآن الوصول إلى هذه النماذج عبر واجهة OpenAI البرمجية (API)، باستخدام حزمة Agents SDK.

في حين تنصح الشركة باستخدام واجهتها للتفاعل الفوري Realtime API عند الحاجة إلى تحويل مباشر للكلام.

تجدر الإشارة إلى أن OpenAI كانت قد أطلقت في مارس 2024 نظام Voice Engine، الذي اقتصر استخدامه آنذاك على منتجات الشركة والعملاء المحددين.

ويبدو أن النموذج الجديد gpt-4o-mini-tts قد جاء ليحل محله، ويوفر إمكانيات أوسع وأكثر تكاملًا.

وفي تحول عن نهجها السابق، لن تتيح الشركة هذه النماذج الجديدة بشكل مفتوح كما فعلت مع Whisper.

وأرجعت ذلك إلى كبر حجم النماذج الحالية الذي يجعل من الصعب تشغيلها على الأجهزة الشخصية.

وبدلاً من هذا، تخطط لاحقًا لتطوير نسخ أخف يمكن مشاركتها كمصدر مفتوح، بحيث تكون مخصصة للعمل مباشرة على الأجهزة عند جاهزيتها.