هل كذبت xAI على الجمهور بشأن ذكاء Grok 3؟

أثارت معايير تقييم نماذج الذكاء الاصطناعي جدلًا واسعًا بين الشركات المطورة. حيث تبادلت كل من xAI، الشركة التي أسسها إيلون ماسك، وOpenAI، اتهامات بشأن دقة النتائج المنشورة حول أداء النموذج الجديد Grok 3.

بدأت القصة عندما نشر أحد موظفي OpenAI منشورًا يتهم xAI بتقديم نتائج مضللة حول أداء Grok 3 مقارنة بمنافسه o3-mini-high من OpenAI.

ومن جانبه، دافع المؤسس المشارك لـ xAI، إيغور بابوشكين، عن نزاهة النتائج التي قدمتها شركته.

Completely wrong. We just used the same method you guys used 🤷♂️ pic.twitter.com/exLcS0z2xI– Igor Babuschkin (@ibab) February 20, 2025

كيف بدأت الأزمة؟

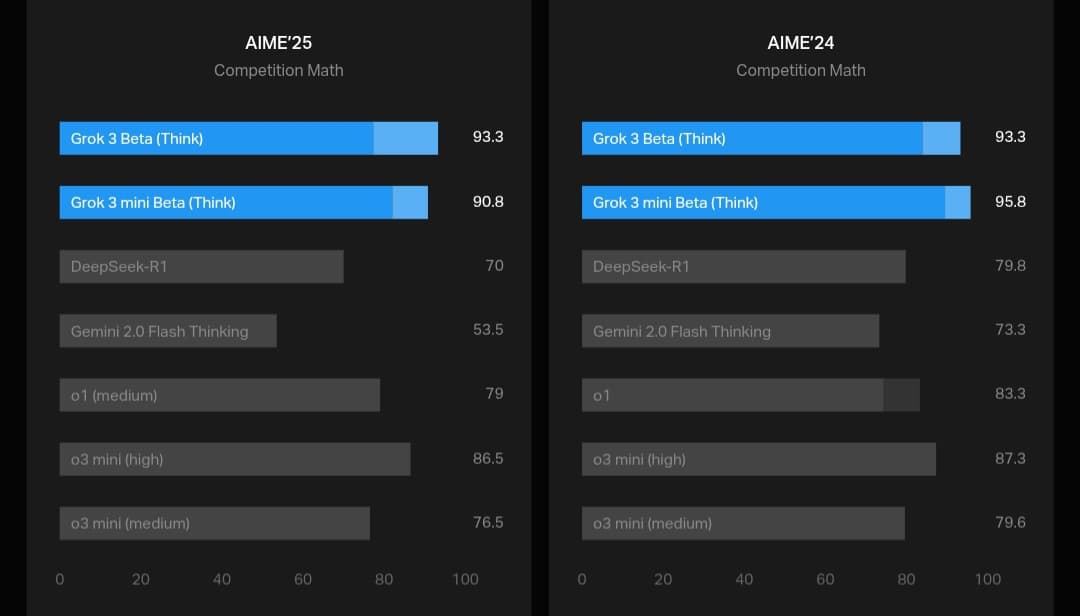

نشرت xAI رسمًا بيانيًا على مدونتها الرسمية يظهر أداء Grok 3 في اختبار AIME 2025، وهو مجموعة من المسائل الرياضية المعقدة المستمدة من امتحان رياضيات دولي حديث.

ورغم التشكيك في مدى صلاحية AIME كمعيار لتقييم قدرات الذكاء الاصطناعي، فإنه يتم استخدامه على نطاق واسع لاختبار مدى كفاءة النماذج في حل المسائل الرياضية.

وأظهر الرسم البياني أن نسختين من Grok 3، وهما Grok 3 Reasoning Beta وGrok 3 mini Reasoning، تفوقتا على نموذج o3-mini-high في اختبار AIME 2025.

غير أن موظفي OpenAI سارعوا إلى الإشارة إلى أن الرسم البياني لم يتضمن نتيجة o3-mini-high عند استخدام معيار «cons@64».

ما هو معيار «cons@64» ولماذا هو مهم؟

يشير «cons@64» إلى «consensus@64″، وهو أسلوب يسمح للنموذج بمحاولة الإجابة على السؤال 64 مرة، ثم يتم اعتماد الإجابة الأكثر تكرارًا كإجابة نهائية.

وهذا الأسلوب يعزز بشكل كبير من درجات النماذج في الاختبارات، مما يجعل استبعاده من المقارنة أمرًا مثيرًا للجدل، لأنه قد يوحي بأن Grok 3 يتفوق على o3-mini-high بينما الحقيقة قد تكون مختلفة.

وعند مقارنة أداء النماذج بدون هذا الأسلوب (عند «@1″، أي باستخدام المحاولة الأولى فقط للإجابة)، يتضح أن أداء Grok 3 Reasoning Beta وGrok 3 mini Reasoning أقل من o3-mini-high.

كما أن Grok 3 Reasoning Beta جاء خلف نموذج OpenAI الآخر o1 medium بفارق بسيط، رغم أن xAI تسوق Grok 3 باعتباره «أذكى ذكاء اصطناعي في العالم«.

اتهامات متبادلة بين xAI وOpenAI

دافع بابوشكين عن شركته مشيرًا إلى أن OpenAI نفسها سبق أن استخدمت رسومًا بيانية قد تكون مضللة عند مقارنة إصدارات نماذجها الخاصة.

وفي المقابل، تدخل باحثون مستقلون لإعادة تقييم النتائج ونشروا رسومًا بيانية توضح أداء جميع النماذج باستخدام معيار «cons@64″، مما قدم صورة أكثر شمولًا ودقة.

Hilarious how some people see my plot as attack on OpenAI and others as attack on Grok while in reality it’s DeepSeek propaganda

(I actually believe Grok looks good there, and openAI’s TTC chicanery behind o3-mini-*high*-pass@»»»1″»» deserves more scrutiny.) https://t.co/dJqlJpcJh8 pic.twitter.com/3WH8FOUfic– Teortaxes▶️ (DeepSeek 推特🐋铁粉 2023 – ∞) (@teortaxesTex) February 20, 2025

لماذا لا تعكس التقييمات الصورة الكاملة؟

يشير الباحث ناثان لامبرت إلى أن هناك عاملًا أساسيًا آخر غائبًا عن معظم هذه النقاشات: التكلفة الحاسوبية والمالية لكل نموذج أثناء الاختبار.

فالنتائج وحدها لا تكشف عن الموارد الضخمة التي يحتاجها كل نموذج للوصول إلى أدائه الأمثل، وهو ما يجعل تقييم الذكاء الاصطناعي أكثر تعقيدًا من مجرد مقارنة الأرقام.

اقرأ أيضًا: مقارنة أداء Grok-3 أمام نماذج الذكاء الاصطناعي الشهيرة.

هل تؤثر هذه المعايير على مصداقية الشركات؟

يبرز هذا الجدل مشكلة أعمق في مجال الذكاء الاصطناعي: كيف تُعرض نتائج الاختبارات؟

فبينما تسعى الشركات لإبراز تفوق نماذجها، قد يتم انتقاء البيانات بعناية بطريقة تؤثر على كيفية فهم الجمهور للأداء الحقيقي.

ولذلك، يظل السؤال الأهم هو: إلى أي مدى يمكن الاعتماد على هذه التقييمات عند قياس ذكاء النماذج؟