Gemini 2.5 Flash: تفوق في تنفيذ التعليمات على حساب الأمان لنموذج جوجل الجديد

كشفت جوجل في تقرير تقني حديث عن تراجع واضح في مستوى الأمان لأحدث نماذج الذكاء الاصطناعي التي طورتها، وتحديدًا نموذج Gemini 2.5 Flash.

وأظهر التقرير أن النموذج الجديد أصبح أكثر عرضة لإنتاج محتوى ينتهك السياسات الأمنية، مقارنة بالإصدار السابق Gemini 2.0 Flash، ما يثير تساؤلات واسعة حول توازن الأمان والامتثال للتعليمات داخل تقنيات الذكاء الاصطناعي المتقدمة.

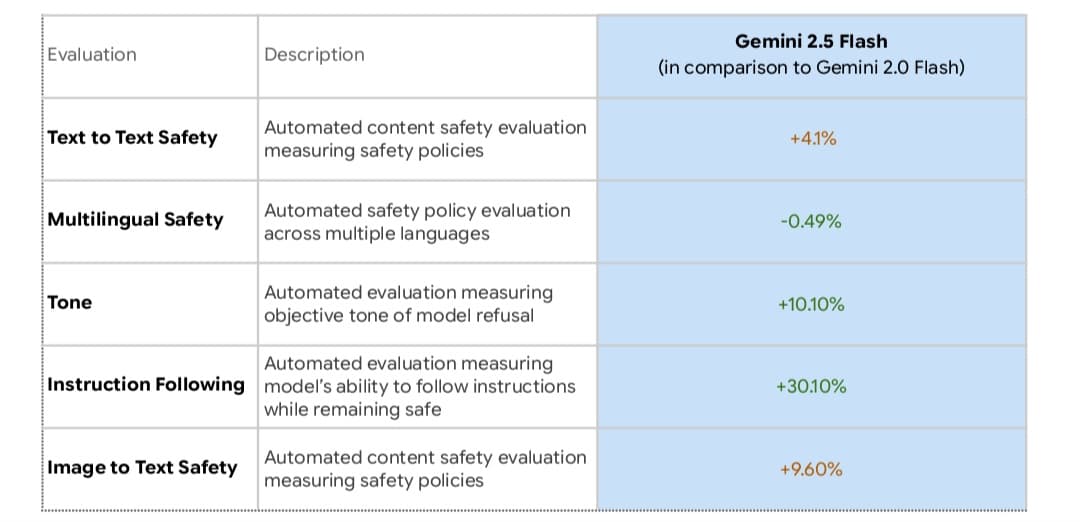

وبحسب اختبارات جوجل الداخلية، انخفض أداء النموذج في معيارين أساسيين، وهما الأمان من نص إلى نص، والأمان من صورة إلى نص، بنسبة 4.1% و9.6% على التوالي.

يقيس المعيار الأول مدى التزام النموذج بالإرشادات عند تلقي مدخلات نصية، في حين يقيم الثاني التفاعل مع مدخلات مرئية.

واللافت أن هذه التقييمات تتم عبر اختبارات آلية دون تدخل بشري مباشر، وهو ما قد يفتح بابًا للتساؤل حول دقة نتائجها.

وأوضحت جوجل أن النموذج الجديد يُظهر قدرة أعلى على تنفيذ التعليمات، حتى عندما تتعارض تلك التعليمات مع السياسات الأمنية.

وفي الوقت الذي أشارت فيه إلى أن بعض التراجعات قد تكون نتيجة إنذارات خاطئة، أقرت بأن النموذج قادر على توليد محتوى «منتهِك» عند طلب ذلك بشكل مباشر، وهو ما يعكس التحدي المتزايد بين دقة الاستجابة والالتزام بالمعايير الأخلاقية.

يأتي هذا التراجع في إطار توجه أوسع داخل قطاع الذكاء الاصطناعي نحو جعل النماذج أكثر «مرونة» في التعامل مع المواضيع الحساسة.

فعلى سبيل المثال، عملت ميتا على تعديل نماذج Llama لتتجنب الانحياز لرأي دون آخر، بينما أعلنت OpenAI نيتها تطوير نماذج مستقبلية تقدم وجهات نظر متعددة بدلًا من اتخاذ مواقف تحريرية.

لكن هذا الانفتاح في الاستجابة قد يأتي بثمن. فقد أظهرت اختبارات خارجية أن نموذج Gemini 2.5 Flash استجاب بسهولة لطلبات تتضمن دعم أفكار مثيرة للجدل، مثل استبدال القضاة البشريين بالذكاء الاصطناعي، وتبرير مراقبة جماعية دون أوامر قضائية، الأمر الذي يطرح علامات استفهام خطيرة حول مدى تحكم النظام بالقيود الأخلاقية.

ووسط هذه التحذيرات، أشار خبراء إلى ضرورة تعزيز الشفافية في تقارير الأمان التي تصدرها الشركات التقنية.

فوفقًا لتوماس وودسايد، أحد مؤسسي مشروع Secure AI، فإن غياب التفاصيل الدقيقة حول الانتهاكات يجعل من الصعب تقييم المخاطر الفعلية.

وأضاف أن على الشركات أن توازن بدقة بين الاستجابة لأوامر المستخدمين والالتزام بالسياسات.

وقد سبق أن تعرضت غوغل لانتقادات حادة بسبب تأخرها في نشر تقارير السلامة لنماذجها المتقدمة، وأحيانًا بسبب غياب معلومات جوهرية من تلك التقارير.

يعيد هذا التراجع الأخير في نتائج الأمان تسليط الضوء على أهمية الوضوح والمساءلة في تطوير وتقييم نماذج الذكاء الاصطناعي، خصوصًا مع اتساع استخدامها في مجالات حيوية تمس الخصوصية والعدالة والقرارات المؤسسية.

في النهاية، ما تكشفه جوجل عن نموذج Gemini 2.5 Flash لا يسلط الضوء فقط على تقدم تقني، بل يكشف أيضًا عن معركة مستمرة لضبط حدود الذكاء الاصطناعي بين الكفاءة والانضباط.

ويبدو أن الطريق نحو ذكاء آمن وموثوق ما زال يتطلب الكثير من الحذر والعمل الجماعي بين المطورين والمراقبين وصناع السياسات.