علي بابا تنافس بنموذج Qwen2.5-Omni: ذكاء اصطناعي يتحدث ويسمع وينظر

كشفت مجموعة علي بابا الصينية العملاقة عن أحدث ابتكاراتها، وهو نموذج ذكاء اصطناعي جديد يحمل اسم «Qwen2.5-Omni-7B»، مع قدرات فائقة على التعامل مع مجموعة متنوعة من البيانات

ما هو نموذج Qwen2.5-Omni

«Qwen2.5-Omni-7B» هو أحدث إضافة لسلسلة نماذج «Qwen» للذكاء الاصطناعي من علي بابا.

وهو نموذج متعدد الوسائط (multimodal)، بمعنى أنه قادر على استقبال أنواع مختلفة من البيانات (نص، صورة، صوت، فيديو) والتفاعل معها.

كما يتميز بحجمه الصغير نسبيًا (7 مليار معلمة)، الأمر الذي يسمح بتشغيله مباشرة على أجهزة المستخدمين دون الحاجة لقوة حوسبة سحابية ضخمة، مع الحفاظ على أداء قوي.

قدرات Qwen2.5-Omni

يستطيع «Qwen2.5-Omni» القيام بمهام متنوعة؛ فهو يرى ويسمع ويتحدث ويكتب، بحسب وصف الشركة.

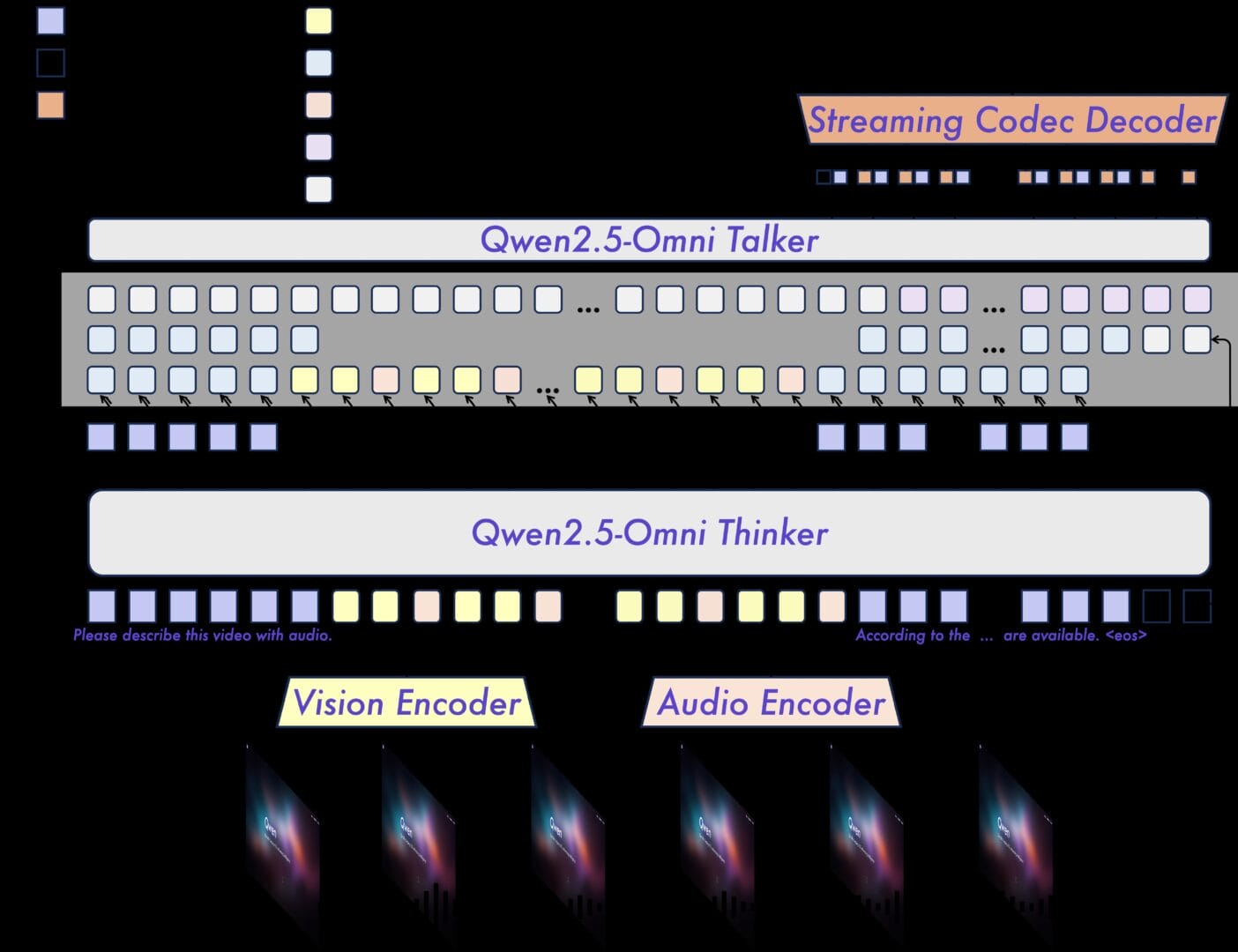

تعتمد هذه القدرات الشاملة على بنية جديدة أطلقت عليها علي بابا اسم «Thinker-Talker» (المفكر والمتحدث).

يعمل «المفكر» كدماغ للنظام، حيث يعالج ويفهم المدخلات المختلفة من نصوص وصوت وصور، بينما يعمل «المتحدث» كالفم، فيأخذ المخرجات من المفكر ويحولها إلى نصوص أو كلام طبيعي بشكل فوري ومتدفق.

ومن الجوانب التقنية، يقدم النموذج تقنية جديدة لمزامنة توقيت الصوت والصورة في مقاطع الفيديو (TMRoPE)، ويدعم التفاعل الفوري باستقبال البيانات ومعالجتها وإخراج النتائج بشكل متزامن.

أبرز مميزات Qwen2.5-Omni

1. دعم كامل للوسائط المتعددة

النموذج قادر على فهم وتحليل المحتوى النصي، البصري، والسمعي بشكل متكامل.

2. بنية Thinker-Talker المبتكرة

يعتمد النموذج على نظام «Thinker-Talker» لتوليد استجابات طبيعية سواء كانت نصية أو صوتية.

3. مزامنة دقيقة للصوت والصورة

يقدم تقنية TMRoPE الجديدة لضمان توافق التوقيت الزمني بين الصوت والصورة في مقاطع الفيديو.

4. استجابة فورية

يتميز بقدرته على معالجة البيانات بسرعة فائقة، حيث يدعم استقبال البيانات ومعالجتها وإخراج النتائج بشكل شبه لحظي.

5. توليد كلام طبيعي

يظهر قدرة عالية على إنتاج كلام منطوق يتسم بالوضوح والطبيعية والجودة، ويتفوق في هذا الجانب على بعض البدائل القائمة.

6. اتباع التعليمات الصوتية

يبرهن على كفاءة عالية في فهم وتنفيذ الأوامر المعطاة صوتيًا، بنفس مستوى كفاءته مع الأوامر النصية.

شاهد قدرات النموذج الفائقة.

أداء النموذج في الاختبارات القياسية

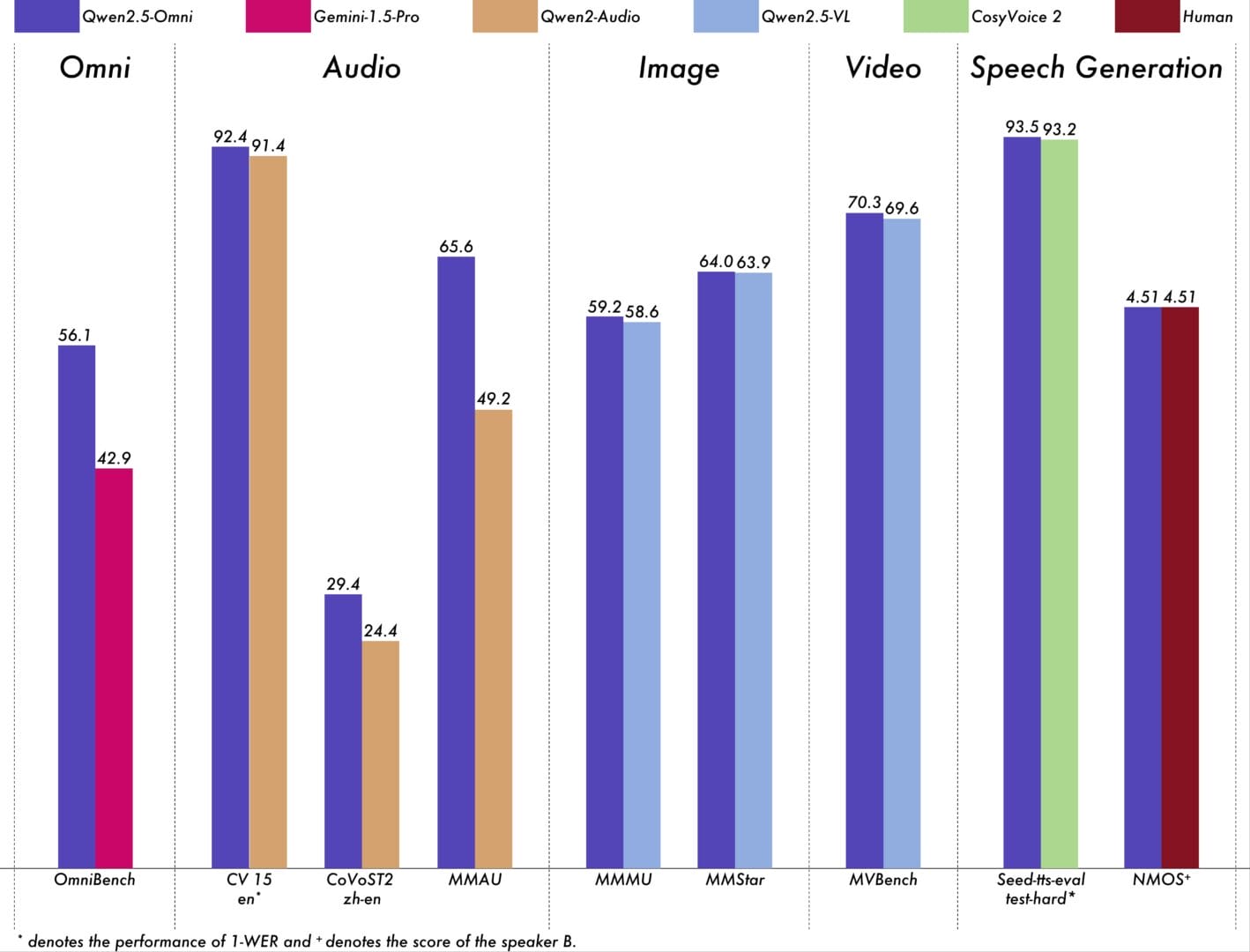

تؤكد علي بابا على الأداء القوي لنموذجها الجديد في مختلف المقاييس والاختبارات المعيارية.

وتشير النتائج المنشورة إلى تفوقه في مهام محددة مقارنة بنماذج منافسة أو إصدارات سابقة من الشركة نفسها.

فعلى سبيل المثال، سجل درجة 56.1 في اختبار «OmniBench» المخصص للقدرات متعددة الوسائط، متجاوزًا نموذج «Gemini-1.5-Pro» من جوجل (42.9).

كما أظهر تفوقًا في اختبارات فهم الصوت مثل «CV15» مقارنة بنموذج «Qwen2-Audio». وحقق نتائج قوية تضاهي نماذج متخصصة في فهم الصور مثل «Qwen2.5-VL-7B» في اختبارات مثل «MMMU».

تطبيقات عملية محتملة للنموذج

يمكن استخدام النموذج في العديد من المجالات، ومن بين الأمثلة التي ذكرتها علي بابا:

1. مساعدة ذوي الإعاقة البصرية: عبر تحويل المشاهد المصورة إلى أوصاف صوتية.

2. المساعدات الذكية: مثل تقديم إرشادات تفاعلية أثناء الطهي بناءً على المكونات المتاحة.

3. تحليل الفيديوهات والصوتيات: لتحسين تجربة المستخدم في تطبيقات الوسائط المتعددة.

خطط التطوير المستقبلية

تطمح علي بابا إلى تحسين قدرات النموذج بشكل أكبر، خصوصًا في مجالات فهم الأوامر الصوتية بدقة وتحليل البيانات المتعددة الوسائط.

وتهدف الشركة على المدى الطويل إلى دمج المزيد من أنواع البيانات والقدرات للوصول إلى نموذج ذكاء اصطناعي «شامل» (Omni-model).

مستقبل متفائل للنماذج متعددة الوسائط

مع التطورات المتلاحقة في مجال الذكاء الاصطناعي، يتجه العالم نحو النماذج متعددة الوسائط التي يمكنها التعامل مع أنواع مختلفة من البيانات، وليس النصوص فقط.

ففي هذا الأسبوع، أعلنت شركة OpenAI عن إضافة قدرات توليد الصور إلى نموذجها GPT-4o.

كما كشفت شركة ByteDance، المالكة لتطبيق TikTok، عن أداة «InfiniteYou» التي يمكنها إعادة صياغة الصور مع الحفاظ على هوية الأشخاص.

وفي يناير الماضي، أطلقت شركة DeepSeek نموذج Janus-Pro، وهو نسخة محدثة من نموذجها متعدد الوسائط الذي تم إطلاقه في أكتوبر.

أسئلة شائعة

هل Qwen2.5-Omni مجاني، وكيف يمكن تجربته؟

نعم، النموذج مفتوح المصدر، وهو متاح مجانًا على منصات Hugging Face، و GitHub، و ModelScope التابعة لعلي بابا. كما يمكن تجربته مباشرة عبر واجهة «Qwen Chat» الخاصة بالشركة.

اطلع أيضًا على طرق الوصول في صفحة النموذج

ما الذي يجعله مميزًا؟

قدرته على التعامل مع مختلف أنواع البيانات، وتصميمه الذي يسمح بتشغيله على الأجهزة المحمولة، بالإضافة إلى كونه مفتوح المصدر.

هل يمكن تشغيله بدون إنترنت؟

نعم، النموذج مصمم ليعمل محليًا على الأجهزة الشخصية، لتعزيز خصوصية المستخدمين.